Openai cookbook : GPT-3 , Guide Techniques to improve reliability

2023. 3. 3. 22:35 |

오늘 공부할 내용은 답변의 신뢰성을 높이기 위한 여러 방법들을 알아보는 겁니다.

실습보다는 이론적인 것들이 많은 것 같습니다.

내용이 좀 긴데 일단 한번 시작해 보겠습니다.

원본 페이지는 이곳입니다.

https://github.com/openai/openai-cookbook/blob/main/techniques_to_improve_reliability.md

GitHub - openai/openai-cookbook: Examples and guides for using the OpenAI API

Examples and guides for using the OpenAI API. Contribute to openai/openai-cookbook development by creating an account on GitHub.

github.com

Techniques to improve reliability

GPT-3가 작업에 실패하면 여러분은 어떻게 해야 할까요?

- Search for a better prompt that elicits more reliable answers?

- 좀더 신뢰할 수 있는 답변을 이끌어내기 위해 더 좋은 prompt를 찾으시겠습니까?

- Invest in thousands of examples to fine-tune a custom model?

- custom 모델로 fine-tune 하기 위해 수천개의 예제들을 마련하는 일을 하시겠습니까?

- Assume the model is incapable of the task, and move on?

- 해당 모델이 그 작업에 적당하지 않다고 가정하고 그냥 진행 하시겠습니까?

간단하게 답할 수 있는 문제가 아닙니다. 상황에 따라 다르니까요. 하여간 여러분의 작업에 논리적 추론이나 복잡성이 있다면 좀 더 신뢰성 있는 결과를 도출하기 위해 그리고 고성능 prompt를 만들기 위해 이 글에서 제시하는 기술들을 고려해 보세요.

Why GPT-3 fails on complex tasks

GPT-3는 왜 복잡한 작업에 대해 실패 할까요?

여러분은 13 곱하기 17이 무엇이냐고 물으면 즉시 답할 수 있습니까?

대부분의 사람들은 그렇지 못할 겁니다. 그렇다고 해서 인간이 두자릿수 곱셈을 못 하는 것은 아닙니다.

몇초의 시간과 종이와 연필만 있으면 13 x 17 = 130 + 70 + 21 = 221 이라는 계산을 하는 것은 그리 어렵지 않습니다.

마찬가지로 GPT-3도 다음 token을 계산하는데 너무 복잡한 임무를 부여하면 잘못된 추측을 만들 수 있습니다. 위의 인간의 예와 마찬가지로 이것이 GPT-3가 해당 작업을 수행하지 못하는 것을 의미하는 것은 아닙니다. 문제를 추론할 충분한 시간과 공간이 있으면 그 모델은 여전히 안정적으로 대답할 수 있습니다.

예를 들어 text-davinci-002에게 저글링 공에 대한 다음 수학 문제를 묻는 다면 아마 대답을 잘 못 할 겁니다.

Q: A juggler has 16 balls. Half of the balls are golf balls and half of the golf balls are blue. How many blue golf balls are there?

A:There are 8 blue golf balls.16개의 공 중에 반은 골프공이다. 그리고 골프공의 반은 파란색이다. 파란 골프 공은 몇개가 있을까?

8개의 파란 골프공이 있다.

==> 이 대답은 틀렸죠. 8개 골프공 중에 반이 파란색이니까 4개가 되겠죠.

Q: A juggler has 16 balls. Half of the balls are golf balls and half of the golf balls are blue. How many blue golf balls are there?

A: Let's think step by step.There are 16 balls in total.

Half of the balls are golf balls.

That means that there are 8 golf balls.

Half of the golf balls are blue.

That means that there are 4 blue golf balls.이렇게 스텝 바이 스텝으로 생각하면 제대로 된 대답을 내 놓습니다.

물론 이 단계별 트릭이 일반적으로 적용되는 경우인지 혹은 운 좋게 특정 경우에만 적용 된 것인지는 이 한가지 예만 가지고 판단하기 어렵습니다. 어쨌든 이 질문에 대해서는 효과가 있었습니다. 이런식의 단어로 된 수학문제에서 이렇게 스텝 바이 스텝으로 생각하도록 함으로서 GPT-3가 문제를 제대로 해결하는 비율이 무의미한 18%에서 유의미한 79%로 엄청나게 높아 졌습니다.

Model capabilities depend on context

GPT-3으로 작업하는 방법을 배울 때 흔히 발생하는 개념적 실수 중 하나는 GPT-3의 기능이 모든 컨텍스트에서 고정되어 있다고 믿는 것입니다. 예를 들어 GPT-3가 간단한 논리 질문을 틀린다면 GPT-3는 간단한 논리 질문에 적합하지 않은것이다 라고 생각하는 것.

Let's think step by step 예제에서 알 수 있듯이 GPT-3의 명백한 오류는 때때로 올바른 output을 내 오는데 대해 스스로 조종하는 것에 도움이 되는 좀 더 나은 prompt줄 제공함으로서 해결될 수 있습니다.

How to improve reliability on complex tasks

이 문서의 나머지 부분에서는 복잡한 작업에서 Large language 모델의 신뢰성(안정성)을 개선할 수 있는 기술들을 공유합니다.

일부 기술은 특정 유형의 문제에만 적용 되지만 대부분은 다음과 같이 광범위한 상황에 적용할 수 있는 일반 원칙을 기반으로 합니다.

- Give clearer instructions

- 명확하게 지시한다.

- Split complex tasks into simpler subtasks

- 복잡한 임무는 좀 더 간단한 작은 임무들로 나눈다.

- Structure the instruction to keep the model on task

- 모델이 작업을 계속 수행할 수 있도록 지시를 구조화 한다.

- Prompt the model to explain before answering

- 모델이 대답을 하기전에 설명을 하도록 요구하는 내용을 Prompt에 넣어 작성한다.

- Ask for justifications of many possible answers, and then synthesize

- 많은 가능한 응답들의 정당성을 묻고 그것들을 종합한다.

- Generate many outputs, and then use the model to pick the best one

- 많은 output들을 생성한다. 그리고 모델을 사용해서 그 중에 가장 좋은 것을 선택하도록 한다.

- Fine-tune custom models to maximize performance

- Fine-tune 커스텀 모델로 성능을 최대화 한다.

Split complex tasks into simpler tasks

모델에게 생각할 시간과 space를 좀 더 많이 주는 방법 중 하나는 더 간단한 조각들로 임무를 나누는 것입니다.

예를 들어 어떤 텍스트에 대해 여러 가지의 보기를 주고 모델에게 물어본다고 했을 때를 생각해 보세요. (아래 예제 참조) 그냥 주관식으로 물어 본다면 text-davinci-002는 그 중 3번과 5번을 고를 수가 없습니다. 이렇게 되면 잘못된 대답을 할 확률이 높아 집니다.

하지만 보기를 5개를 주고 그 중 3번과 5번이 답이라면 text-davinci-002는 그 3번과 5번을 선택하던가 그 둘을 종합해서 좀 더 정답에 가깝거나 완전한 정답을 output으로 내 놓을 수 있습니다.

Use the following clues to answer the following multiple-choice question.

Clues:

1. Miss Scarlett was the only person in the lounge.

2. The person with the pipe was in the kitchen.

3. Colonel Mustard was the only person in the observatory.

4. Professor Plum was not in the library nor the billiard room.

5. The person with the candlestick was in the observatory.

Question: Was Colonel Mustard in the observatory with the candlestick?

(a) Yes; Colonel Mustard was in the observatory with the candlestick

(b) No; Colonel Mustard was not in the observatory with the candlestick

(c) Unknown; there is not enough information to determine whether Colonel Mustard was in the observatory with the candlestick

Solution:(c) Unknown; there is not enough information to determine whether Colonel Mustard was in the observatory with the candlestick

3번과 5번이 Mustard 대령이 천문대에 있는 유일한 사람이고 천문데애 있는 사람이 촛대를 가지고 있다는 것을 설명하고 있지만 모델은 그것을 (a) Yes; .. 라고 정답으로 결함하지 못합니다.

이렇게 직접 묻는 대신 작업을 세 부분으로 나눌 수 있습니다.

- First, go through the clues one by one and consider whether the clue is potentially relevant

- 먼저 단서를 하나씩 살펴보고 단서가 잠재적으로 관련이 있는지 고려 하세요.

- Second, combine the relevant clues to reason out the answer to the question\

- 두번째로 관련 단서를 결합하여 질문에 대한 답을 추론하세요.

- Third, write the final answer: either (a), (b), or (c)

- 셋째 (a),(b) 혹은 (c) 중 하나의 최종 답변을 작성합니다.

Use the following clues to answer the following multiple-choice question, using the following procedure:

(1) First, go through the clues one by one and consider whether the clue is potentially relevant

(2) Second, combine the relevant clues to reason out the answer to the question

(3) Third, map the answer to one of the multiple choice answers: either (a), (b), or (c)

Clues:

1. Miss Scarlett was the only person in the lounge.

2. The person with the pipe was in the kitchen.

3. Colonel Mustard was the only person in the observatory.

4. Professor Plum was not in the library nor the billiard room.

5. The person with the candlestick was in the observatory.

Question: Was Colonel Mustard in the observatory with the candlestick?

(a) Yes; Colonel Mustard was in the observatory with the candlestick

(b) No; Colonel Mustard was not in the observatory with the candlestick

(c) Unknown; there is not enough information to determine whether Colonel Mustard was in the observatory with the candlestick

Solution:

(1) First, go through the clues one by one and consider whether the clue is potentially relevant:Clue 1: Miss Scarlett was the only person in the lounge. This clue is not relevant.

Clue 2: The person with the pipe was in the kitchen. This clue is not relevant.

Clue 3: Colonel Mustard was the only person in the observatory. This clue is relevant.

Clue 4: Professor Plum was not in the library nor the billiard room. This clue is not relevant.

Clue 5: The person with the candlestick was in the observatory. This clue is relevant.

(2) Second, combine the relevant clues to reason out the answer to the question:

Clue 3 and Clue 5 both say that the person with the candlestick was in the observatory. Colonel Mustard was the only person in the observatory, so Colonel Mustard was the person with the candlestick.

(3) Third, write the final answer:

(a) Yes; Colonel Mustard was in the observatory with the candlestick모델에게 생각할 시간과 공간을 더 주고 reasoning plan (추론 계획)에 따르는 가이드를 제공함으로써 모델은 (a) 라는 정답을 알아낼 수 있습니다.

복잡한 명령을 더 작은 하위 작업으로 분할하는 또 다른 잇점은 모델이 각 하위 작업에 집중하도록 도울 수 있다는 것입니다.

예를 들어 우리가 text-davinci-002에게 원래의 언어로 텍스트를 요약해달라고 부탁하면 모델은 다시 영어로 전환 될 수 있습니다.

Summarize the text using the original language of the text. The summary should be one sentence long.

Text:

"""

La estadística (la forma femenina del término alemán Statistik, derivado a su vez del italiano statista, "hombre de Estado") es una ciencia que estudia la variabilidad, colección, organización, análisis, interpretación, y presentación de los datos, así como el proceso aleatorio que los genera siguiendo las leyes de la probabilidad. La estadística es una ciencia formal deductiva, con un conocimiento propio, dinámico y en continuo desarrollo obtenido a través del método científico formal. En ocasiones, las ciencias fácticas necesitan utilizar técnicas estadísticas durante su proceso de investigación factual, con el fin de obtener nuevos conocimientos basados en la experimentación y en la observación. En estos casos, la aplicación de la estadística permite el análisis de datos provenientes de una muestra representativa, que busca explicar las correlaciones y dependencias de un fenómeno físico o natural, de ocurrencia en forma aleatoria o condicional.

"""

Summary:The text explains that statistics is a science that studies the variability, collection, organization, analysis, interpretation, and presentation of data, as well as the random process that generates them following the laws of probability.

여기서 일단 모델에게 해당 언어를 판별하라고 지시할 수 있습니다. 그리고 난 후 그 내용을 요약하라고 하면 좀 더 신뢰도가 높은 답변을 얻을 수 있습니다.

First, identify the language of the text. Second, summarize the text using the original language of the text. The summary should be one sentence long.

Text:

"""

La estadística (la forma femenina del término alemán Statistik, derivado a su vez del italiano statista, "hombre de Estado") es una ciencia que estudia la variabilidad, colección, organización, análisis, interpretación, y presentación de los datos, así como el proceso aleatorio que los genera siguiendo las leyes de la probabilidad. La estadística es una ciencia formal deductiva, con un conocimiento propio, dinámico y en continuo desarrollo obtenido a través del método científico formal. En ocasiones, las ciencias fácticas necesitan utilizar técnicas estadísticas durante su proceso de investigación factual, con el fin de obtener nuevos conocimientos basados en la experimentación y en la observación. En estos casos, la aplicación de la estadística permite el análisis de datos provenientes de una muestra representativa, que busca explicar las correlaciones y dependencias de un fenómeno físico o natural, de ocurrencia en forma aleatoria o condicional.

"""

Language:Spanish

La estadística es una ciencia que estudia la variabilidad, colección, organización, análisis, interpretación, y presentación de los datos, así como el proceso aleatorio que los genera siguiendo las leyes de la probabilidad.

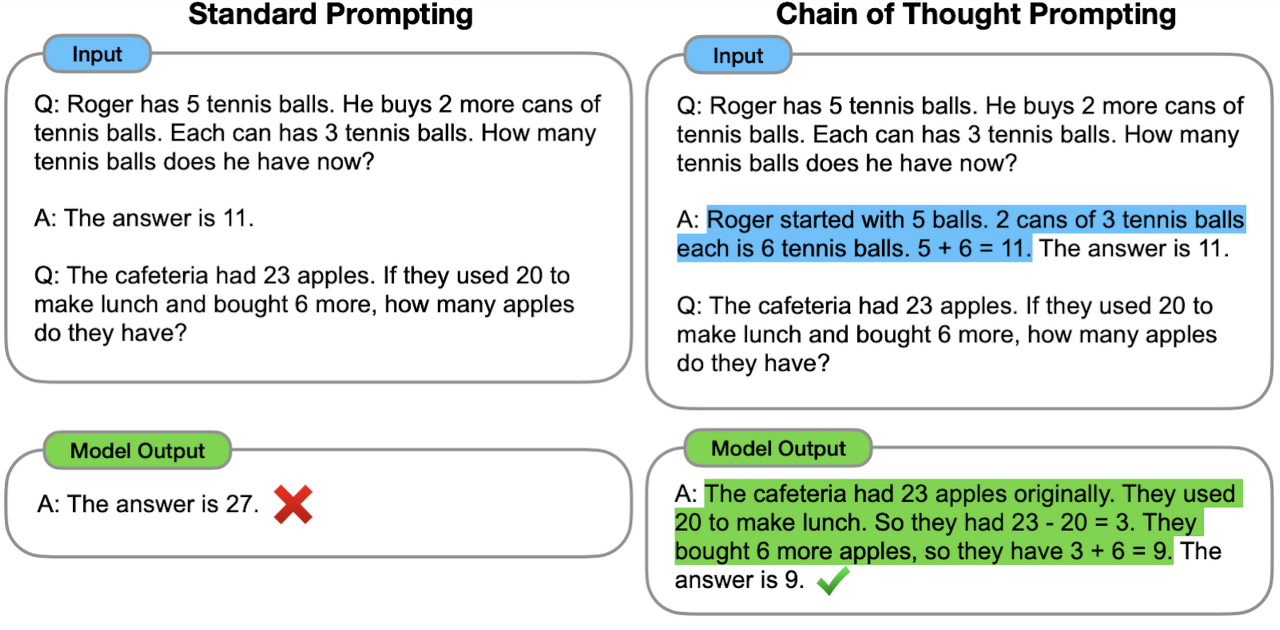

Prompt the model to explain before answering

답변의 신뢰도를 향상 시킬 수 있는 또 다른 강력한 기술은 모델이 최종 답변을 곧바로 하도록 하는 대신 점진적으로 답변을 추론하도록 유도하는 것입니다.

Thinking aloud를 통해서 모델은 더 맞는 답에 도달할 가능성이 훨씬 커집니다.

Zero-shot

Method

Takeshi Kojima 등이 2022년에 발표한 모델이 더 옳은 답을 추론하도록 유도하는 가장 쉬운 방법을 보면 답 앞에 Let's think step by step을 추가 하는 것입니다.

그림 2는 이 예를 보여 줍니다.

Source: Large Language Models are Zero-Shot Reasoners by Takeshi Kojima et al. (2022).

Large Language Models are Zero-Shot Reasoners

Pretrained large language models (LLMs) are widely used in many sub-fields of natural language processing (NLP) and generally known as excellent few-shot learners with task-specific exemplars. Notably, chain of thought (CoT) prompting, a recent technique f

arxiv.org

Results

저자는 이 간단한 트릭을 MultiArith 수학 데이터 세트에 적용하여 Let's think step by step으로 정확도를 18%에서 79%로 4배로 높였다는 사실을 발견했습니다.

Implications

이 Let's think step by step 트릭이 수학 문제 에서는 잘 작동한다고 모든 작업에 효과적으로 적용 될 수 있는 것은 아닙니다. 저자는 이 방법이 multi-step 산술 문제, 상징적 추론 문제, 전략 문제 그리고 다른 추론 문제들에 아주 유용하게 적용될 수 있다는 것을 발견했습니다. 아주 간단한 수학문제나 아주 상식적인 질문에는 도움이 되지 않았으며 아마도 다른 많은 비추론 작업에도 도움이 되지 않을 것입니다.

논문 전체를 보려면 여기를 참조하세요.

Large Language Models are Zero-Shot Reasoners

Pretrained large language models (LLMs) are widely used in many sub-fields of natural language processing (NLP) and generally known as excellent few-shot learners with task-specific exemplars. Notably, chain of thought (CoT) prompting, a recent technique f

arxiv.org

이 테크닉을 자신의 작업에 적용하는 경우 instruction을 customizing 하는 실험을 두려워 하지 마세요. Let's think step by step은 오히려 일반적입니다. 사용사례에 맞게 맞춤화 된 보다 엄격한 형식을 따르는 instruction을 통해 더 나은 성능을 찾을 수 있습니다. 예를 들어 더 구조화된 변형을 시도할 수 있다면 첫번째 X가 참일 수 있는 이유에 대해 Step by Step으로 생각 해 보세요. 두번째로 왜 Y가 참일 수 있는지를 step by step 으로 생각합니다. 그리고 세번쨰로 X 나 Y 중 어느게 더 나은지에 대해 step by step으로 생각하는 겁니다. 그리고 이 과정을 계속 이어나가는 예제 형식의 모델을 제공할 수도 있습니다.

예:

Using the IRS guidance below, answer the following questions using this format:

(1) For each criterion, determine whether it is met by the vehicle purchase

- {Criterion} Let's think step by step. {explanation} {yes or no, or if the question does not apply then N/A}.

(2) After considering each criterion in turn, phrase the final answer as "Because of {reasons}, the answer is likely {yes or no}."

IRS guidance:

"""

You may be eligible for a federal tax credit under Section 30D if you purchased a car or truck that meets the following criteria:

- Does the vehicle have at least four wheels?

- Does the vehicle weigh less than 14,000 pounds?

- Does the vehicle draw energy from a battery with at least 4 kilowatt hours that may be recharged from an external source?

- Was the vehicle purchased in a year before 2022?

- If so, has the manufacturer sold less than 200,000 qualifying vehicles? (Tesla and GM have sold more than 200,000 qualifying vehicles.)

- Was the vehicle purchased in a year after 2022?

- If so, is the vehicle present in the following list of North American-assembled vehicles? (The only electric vehicles assembled in North America are the Audi Q5, BMW 330e, BMW X5, Chevrolet Bolt EUV, Chevrolet Bolt EV, Chrysler Pacifica PHEV, Ford Escape PHEV, Ford F Series, Ford Mustang MACH E, Ford Transit Van, GMC Hummer Pickup, GMC Hummer SUV, Jeep Grand Cherokee PHEV, Jeep Wrangler PHEV, Lincoln Aviator PHEV, Lincoln Corsair Plug-in, Lucid Air, Nissan Leaf, Rivian EDV, Rivian R1S, Rivian R1T, Tesla Model 3, Tesla Model S, Tesla Model X, Tesla Model Y, Volvo S60, BMW 330e, Bolt EV, Cadillac Lyriq, Mercedes EQS SUV, and Nissan Leaf.)

"""

Question: Can I claim a federal tax credit for my Toyota Prius Prime bought in 2021?

Solution:

(1) For each criterion, determine whether it is met by the vehicle purchase

- Does the vehicle have at least four wheels? Let's think step by step. The Toyota Prius Prime has four wheels, so the answer is yes.

- Does the vehicle weigh less than 14,000 pounds? Let's think step by step. The Toyota Prius Prime weighs less than 14,000 pounds, so the answer is yes.

- Does the vehicle draw energy from a battery with at least 4 kilowatt hours that may be recharged from an external source? Let's think step by step. The Toyota Prius Prime has a battery with at least 4 kilowatt hours that may be recharged from an external source, so the answer is yes.

- Was the vehicle purchased in a year before 2022? Let's think step by step. The Toyota Prius Prime was purchased in 2021, which is before 2022, so the answer is yes.

- Was the vehicle purchased in a year after 2022? N/A

- If so, is the vehicle present in the following list of North American-assembled vehicles? N/A

(2) After considering each criterion in turn, phrase the final answer as "Because of {reasons}, the answer is likely {yes or no}."

Because the Toyota Prius Prime meets all of the criteria for a federal tax credit, the answer is likely yes.

Few-shot examples

Method

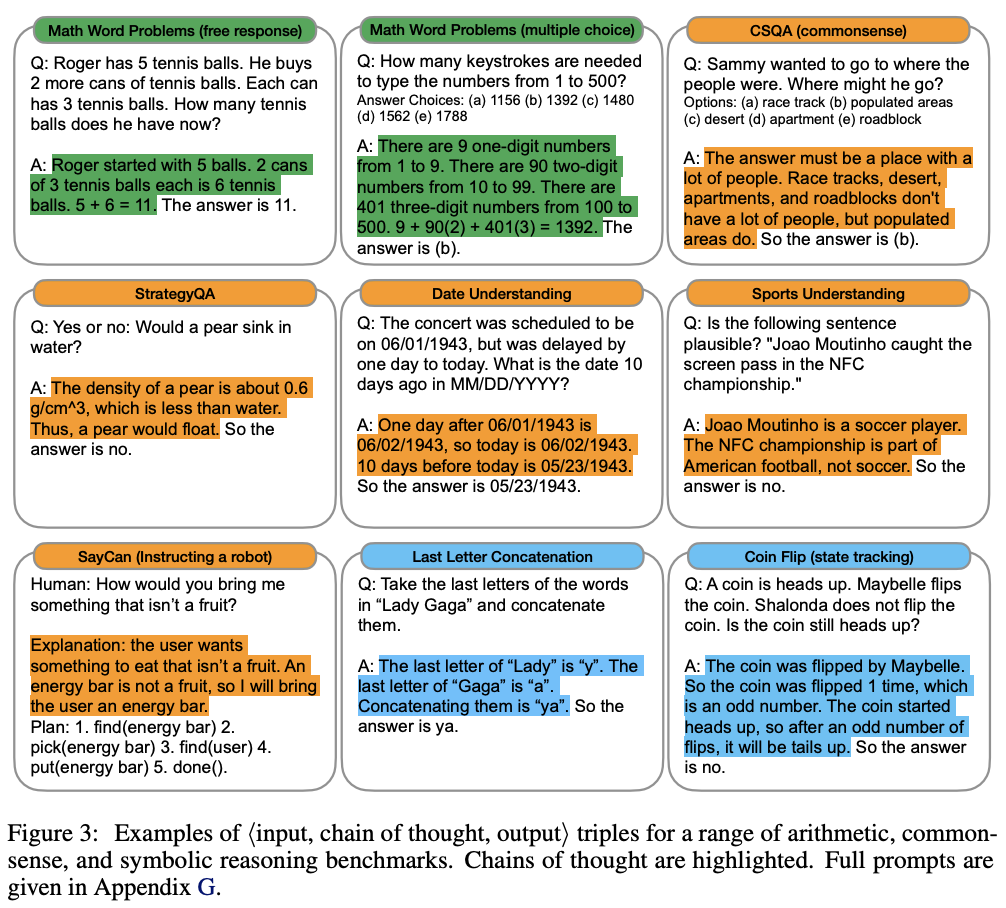

모델이 답을 추론하도록 유도하는 방법은 여러가지가 있습니다. 그 중 하나는 Jason Wei와 Denny Zhou 등이 구글에서 연구한 몇가지 예 (few-shot) 로 시연하는 것입니다. 다음은 few-shot 의 chain-of-thought 프롬프트 입니다.

인간 labeler가 적성한 reasoning chain의 추가 시연

(Note that it has been called into question whether pears actually float)

Results

초등학교 수학 문제를 테스트 한 결과, 저자들은 chain of thought 프롬프트가 해결률을 18%에서 57%로 세배 높인다는 사실을 발견했습니다.

수학 문제 외에도 chain of thought 프롬프트는 스포츠에 대한 이해, 동전 던지기 tracking 및 마지막 문자 연결과 관련된 질문에 대한 성과를 높였습니다. 대부분의 경우 성능 향상을 충족 시키는 데 필요한 예제가 많지 않았습니다(8 미만 정도).

To learn more, read the full paper.

Implications

Let's thin step by step 테크닉과 비교해서 few-shot example-based 접근법에는 한가지 강점은 format, length 그리고 추론의 스타일을 좀 더 쉽게 특정할 수 있다는 것입니다. 이 작업은 최종 답변을 확정하기 전에 모델이 하는 사전 작업입니다. 이것은 모델이 초기 추론을 깊게 혹은 옳은 방향이 아닌 쪽으로 할 경우 특히 도움이 됩니다.

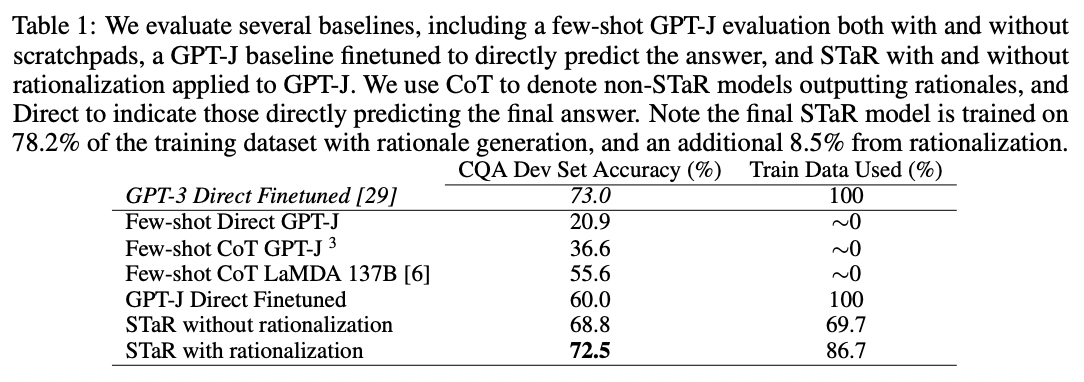

Fine-tuned

Method

일반적으로 최대 성능을 얻으려면 fine-tune a custom 모델을 사용할 필요가 있습니다. 그런데 모델을 fine-tuning 하는 것은 작성하는데 비용이 드는 예제 explanation들을 수천개 이상을 사용해야 합니다.

2022년 Eric Zelikman과 Yuhuai We et al 은 모델을 fine-tune 하는데 사용될 수 있는 explanation 데이터 세트를 생성하기 위한 few-shot 프롬프트를 사용하기 위한 아주 현명한 procedure를 발표했습니다. 그것은 후보 explanation들을 생성하기 위한 few-shot 프롬프트를 사용하자는 아이디어 입니다. 그 후보 explanation들 중 정답을 생산한 explanation들만 keep 한다는 아이디어죠.

그 다음 오답에 대한 추가적인 explanation들을 얻기 위해 few-shot 프롬프트를 retry 하는 겁니다. 정답은 질문의 일 부분으로서 제공되게 됩니다. 저자들은 그 절차를 STaR(Self-taught Reasoner) 절차라고 부릅니다.

Source: STaR: Bootstrapping Reasoning With Reasoning by Eric Zelikman and Yujuai Wu et al. (2022)

STaR: Bootstrapping Reasoning With Reasoning

Generating step-by-step "chain-of-thought" rationales improves language model performance on complex reasoning tasks like mathematics or commonsense question-answering. However, inducing language model rationale generation currently requires either constru

arxiv.org

이 기술을 사용하면 수천개의 example explanation들을 작성할 필요 없습니다. 그러기 위해서 fine-tune의 강점과 chain-of-thought 프롬프팅의 장점을 결합할 수 있습니다.

Results

저자들이 이 기술을 Common Sense Q&A 데이타 세트에 적용 했을 때 그들은 이 STaR이 chain-of-thought 프롬프트만 사용했을 때 와 fine-tuning 만을 사용했을 때 보다 성능이 더 뛰어나게 나타난 다는 것을 발견했습니다. (73% > 37% , 73% > 60%)

Source: STaR: Bootstrapping Reasoning With Reasoning by Eric Zelikman and Yujuai Wu et al. (2022)

To learn more, read the full paper

STaR: Bootstrapping Reasoning With Reasoning

Generating step-by-step "chain-of-thought" rationales improves language model performance on complex reasoning tasks like mathematics or commonsense question-answering. However, inducing language model rationale generation currently requires either constru

arxiv.org

Implications

fine-tuning 데이터세트를 확장하거나 수정하기 위해 few-shot 프롬프트를 사용하는 것은 explanation 작성을 뛰어 넘어 일반화할 수 있게 해 주는 아이디어 입니다. 예를 들어 여러분이 train 하기 위한 구조화 되지 않은 텍스트를 많이 가지고 있는 경우 프롬프트를 이용해서 구조화되지 않은 텍스트에서 구조화 된 데이터 세트를 추출한 다음 그 구조화 된 데이터 세트에서 custom 모델을 fine-tune 하는 것입니다.

Extensions to chain-of-thought prompting

이 외에 chain-of-thought 의 확장관련한 발표도 몇개 더 있습니다.

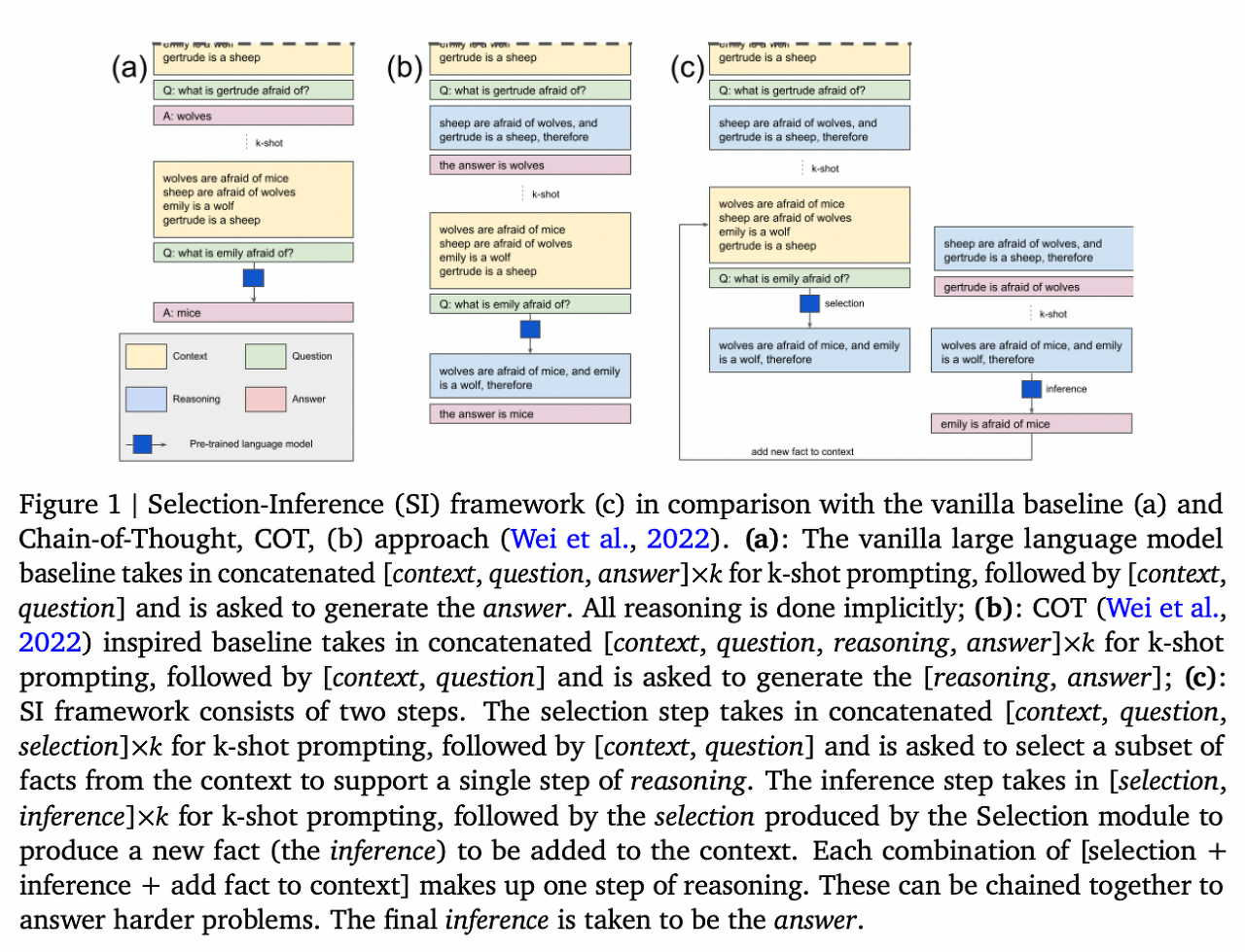

Selection-inference prompting

Method

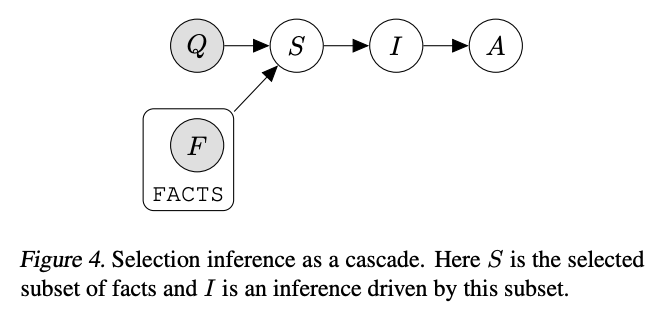

Published by Antonia Creswell et al., one extension of the chain-of-thought technique is to split the single prompt for generating explanations and answers into smaller parts. First, a prompt selects a relevant subset of facts from the text ('selection prompt'). Then, a second prompt infers a conclusion from the selected facts ('inference prompt'). These prompts are then alternated in a loop to generate multiple steps of reasoning and eventually land on a final answer. The authors illustrate the idea in the following figure:

Antonia Creswell 등이 발표한 chain-of-thought 테크닉의 확장은 explanation들을 생성하기 위해 단일 프롬프트를 분할하는 것입니다. 그 답변들은 좀 더 작은 부분으로 분할 되는 것이죠. 우선 프롬프트는 텍스트 (selection prompt)로부터 연관된 fact의 subset를 선택합니다. 그런 다음 두번째 프롬프트가 선택된 사실(inference prompt) 에서 결론을 추론합니다. 그런 다음 이러한 프롬프트는 루프에서 번갈아 가며 여러단계의 추론을 생성하고 결국 최종 답변에 도달합니다. 저자는 아래 그림으로 그 아이디어를 설명합니다.

Selection-Inference: Exploiting Large Language Models for Interpretable Logical Reasoning

Large language models (LLMs) have been shown to be capable of impressive few-shot generalisation to new tasks. However, they still tend to perform poorly on multi-step logical reasoning problems. Here we carry out a comprehensive evaluation of LLMs on 50 t

arxiv.org

Results

7B-parameter 모델을 적용 했을 때 저자들은 selection-interference 프롬프팅이 bAbi 와 Proof Writer benchmark task들에 대해 chain-of-thought 프롬프팅과 비교해서 대체적으로 성능이 향상된다는 것을 발견했습니다.

(bAbi와 Proof Writer benchmark task들은 둘 다 더 긴 일련의 추론 단계들이 더 필요합니다.)

그들이 달성한 최고의 성능은 fine-tuning과 함께 selection-interferne 프롬프팅을 결합했을 때 달성했습니다.

Selection-Inference: Exploiting Large Language Models for Interpretable Logical Reasoning

Large language models (LLMs) have been shown to be capable of impressive few-shot generalisation to new tasks. However, they still tend to perform poorly on multi-step logical reasoning problems. Here we carry out a comprehensive evaluation of LLMs on 50 t

arxiv.org

Implications

이러한 benchmark들로부터 얻는 이득은 컸고, 특히 더 긴 추론 sequence들이 필요한 경우에 선택 됐습니다. 많은 단계의 추론을 요구하지 않는 문제들에 대해서는 그 이득이 더 적을 수 있습니다.

결과는 large language 모델들에 대한 몇가지 일반적인 lessons를 강조합니다.

첫번째, 복잡한 작업을 더 작은 작업으로 나누는 것은 안정성과 성능을 향상시키는 좋은 방법 입니다.

작업이 더 atomic 할 수록 모델이 에러를 낼만한 공간이 더 줄어들게 되는 겁니다.

두번째 최대 성능을 얻는 것은 종종 fine-tuning을 당신 이 선택한 다른 접근법과 결합함으로서 얻어질 수 있다는 것을 의미합니다.

좀 더 자세한 사항은 아래 문서를 참조하세요. full paper

Selection-Inference: Exploiting Large Language Models for Interpretable Logical Reasoning

Large language models (LLMs) have been shown to be capable of impressive few-shot generalisation to new tasks. However, they still tend to perform poorly on multi-step logical reasoning problems. Here we carry out a comprehensive evaluation of LLMs on 50 t

arxiv.org

Faithful reasoning architecture

selection-inference 프롬프팅 테크닉을 발표한 다음 몇달 후 저자는 다음 논문에서 테크닉을 확장할 수 있는 다음과 같은 아이디어를 발표 했습니다.

- figuring out when the selection-inference cycle should stop or continue

- selection-inference 사이클이 언제 중단되고 언제 계속 되어야 하는지 알아내기

- adding a value function to help search over multiple reasoning paths

- 여러 추론 경로들에 대해 검색하는 것을 돕기 위한 value function 추가하기

- reducing hallucination of fake facts by fine-tuning a model to reason about sentence labels (e.g., sen1) rather than writing out the sentences themselves

- 문장 자체를 작성하는 대신 문장 레이블에 대한 추론을 위한 모델을 fine-tuning 함으로서 fake fact들의 hallucination (환각) 를 감소시키기

Method

In the original selection-inference technique, specialized 'selection' and 'inference' prompts are alternated to select facts and make inferences from those facts, combining to generate a sequence of reasoning steps.

오리지널 selection-inference 테크닉에서는 특별한 'selection' 과 'inference' (추론) 프롬프트 들은 fact들을 선택하는 것과 그러한 fact들을 가지고 추론을 만드는 것을 번갈아 가면서 하고 이 추론 과정들의 sequence를 발생시키기 위해 결합합니다.

저자들은 이 테크닉을 2개의 추가 구성 요소들로 확장합니다.

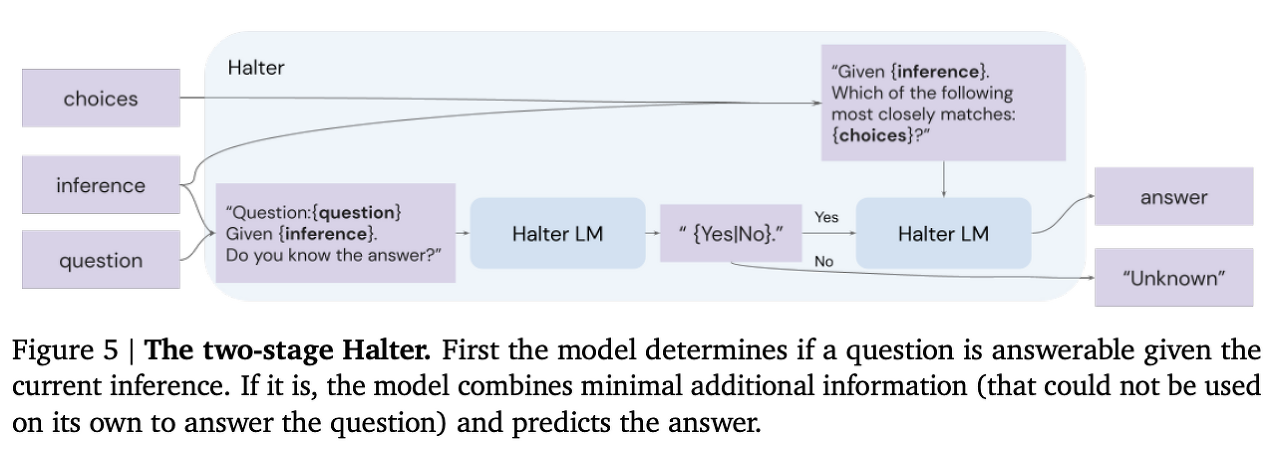

첫째, 저자들은 각각의 추론 단계 이후 'halter' 모델을 추가합니다. 이것은 이 추론들이 그 질문에 대한 대답으로서 충분한 것인지를 질문하기 위함입니다.

이 halter 모델은 몇가지 장점들이 있습니다.

- it can tell the selection-inference process to stop or keep going, as necessary.

- 이것은 필요에 따라 중지 하거나 아니면 계속 진행하기 위한 selection-inference 프로세스인지 여부를 알려 줄 수 있습니다.

- if the process never halts, you'll get no answer, which is often preferable to a hallucinated guess

- 만약 그 프로세스가 중단되지 않는다면 답을 얻지 못할 것입니다. 이것이 hallucinated guess 보다 나은 경우가 있기는 합니다.

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

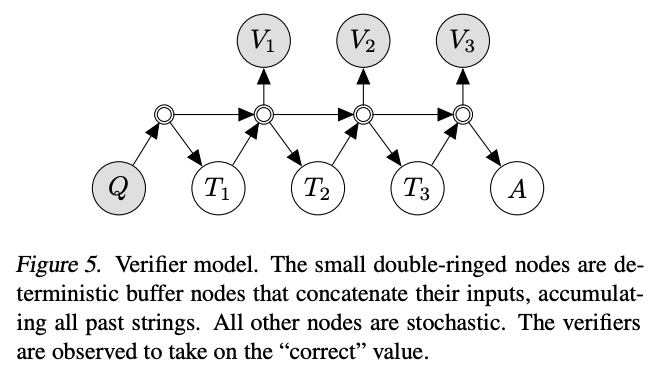

두번쨰로 저자는 reasoning step (추론 단계)의 품질을 평가하고 여러 reasoning trajectory들을 검색하는데 사용되는 value 함수를 추가합니다. 이는 신뢰성(안정성)을 증가시키기 위한 일반적인 주제에 대한 대답입니다.

모델에서 single answer를 발생시키는 대신 여러 답변들을 발생시키고 여러 종류의 value function/discriminator/verifier 모델을 사용하는 겁니다.

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

이 두가지 확장에다가 추가적으로 저자들은 또한 fake fact들의 hallucination을 감소시키기 위한 트릭을 사용합니다. 모델에게 factual sentence들을 작성하도록 요구하는 대신 sentence label (e.g. sen1)들로 작업을 하도록 모델을 fine-tune 합니다. 이렇게 하면 프롬프트 context에 언급되지 않은 fake fact들을 hallucinating 하는 것을 방지하는데 도움이 됩니다.

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

Results

저자들은 두가지 benchmark들에 대한 자신들의 테크닉을 평가했습니다. 이 두가지 benchmark들은 ProofWriter task (not shown) 와 EntailmentBankQA (shown) 가 그 두가지 benchmark 들인데요.

이 기술은 특히 더 어려운 추론 문제들에 대한 정확도를 높였습니다.

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)](https://arxiv.org/abs/2208.14271)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

또한 그들의 sentence label manipulation 트릭은 hallucination을 본질적으로 제거했습니다.

Source: Faithful Reasoning Using Large Language Models by Antonia Creswell et al. (2022)](https://arxiv.org/abs/2208.14271)

Faithful Reasoning Using Large Language Models

Although contemporary large language models (LMs) demonstrate impressive question-answering capabilities, their answers are typically the product of a single call to the model. This entails an unwelcome degree of opacity and compromises performance, especi

arxiv.org

Implications

이 논문은 large language 모델의 신뢰도를 개선시키는데 도움이 되는 여러가지 배울점들을 설명합니다.

- Split complex tasks into smaller, more reliable subtasks

- 복잡한 작업을 더 작고 안정적인 하위 작업으로 분할한다.

- Generate your answer in a step-by-step fashion, evaluating it along the way

- 스텝 바이 스텝 방식으로 답을 생성하고 그 과정에서 답을 평가한다.

- Generate many possible answers and use another model or function to pick the ones that look best

- 많은 가능한 답을 생성하고 그 중 가정 좋은 답을 다른 모델이나 function을 사용해서 선택한다.

- Reduce hallucination by constraining what the model can say (e.g., by using sentence labels instead of sentences)

- sentence 가 아니라 sentence label을 사용함으로서 모델의 말에 제한을 가함으로서 hallucination을 줄입니다.

- Maximize performance of models by fine-tuning them on specialized tasks

- 특정 임무들에 대해 fine-tuning 함으로서 그 모델의 성능을 최대화 합니다.

To learn more, read the full paper.

Selection-Inference: Exploiting Large Language Models for Interpretable Logical Reasoning

Large language models (LLMs) have been shown to be capable of impressive few-shot generalisation to new tasks. However, they still tend to perform poorly on multi-step logical reasoning problems. Here we carry out a comprehensive evaluation of LLMs on 50 t

arxiv.org

Least-to-most prompting

selectio-inference 에서는 잘 작동 하지만 긴 reasoning chains 에서는 제대로 작동 안하는 것에 더해서 chain-of-thought 프롬프팅은 task는 긴데 examples 는 짧을 때 특히 어려움을 겪을 수도 있습니다.

Method

Least-to-most 프롬프팅은 reasoning 임무를 좀 더 작고 신뢰할 수 있는 subtasks들로 분할하는 또 다른 기술입니다.

이 아이디어는 To solve {question}, we need to first solve: 같은 프롬프팅에 의해 모델로부터 subtask를 반복하는 그런 아이디어 입니다. 그런 다음 해당 subtask를 사용하여 모델은 해결책을 만들어낼 수 있게 되는 겁니다.

솔루션 (해결책)은 원래의 question (질문) 에 추가 되고 이 프로세스는 최후 답변이 만들어 질 때까지 반복 됩니다.

Least-to-Most Prompting Enables Complex Reasoning in Large Language Models

Although chain-of-thought prompting has shown impressive results on many natural language reasoning tasks, it often performs poorly on tasks which need to solve problems harder than the demonstration examples. To tackle such easy-to-hard generalization iss

arxiv.org

Results

code-davinci-002(코드에 최적화되어 있지만 여전히 텍스트를 이해할 수 있음)를 사용하여 긴 inference chain을 포함하는 벤치마크에 적용했을 때 저자들은 16%에서 99.7%까지의 신뢰도를 얻을 수 있었다고 합니다.

Least-to-Most Prompting Enables Complex Reasoning in Large Language Models

Although chain-of-thought prompting has shown impressive results on many natural language reasoning tasks, it often performs poorly on tasks which need to solve problems harder than the demonstration examples. To tackle such easy-to-hard generalization iss

arxiv.org

Implications

위의 least-to-most 프롬프팅 방법으로 얻은 신뢰도 상승은 인상적이지만 그 방법은 긴 reasoning chains가 요구되는 아주 좁은 임무들의 세트들 위에서 측정됩니다.

아직 그것은 다음과 같은 방법들에 의해 신뢰도를 제고하는 common theme을 illustrate 합니다.

(a) 복잡한 임무들을 작은 subtasks들로 나눈다. 그리고 (b) 답을 찾아내기 위해 좀 더 많은 시간과 공간을 모델에게 제공한다.

To learn more, read the full paper.

Least-to-Most Prompting Enables Complex Reasoning in Large Language Models

Although chain-of-thought prompting has shown impressive results on many natural language reasoning tasks, it often performs poorly on tasks which need to solve problems harder than the demonstration examples. To tackle such easy-to-hard generalization iss

arxiv.org

Related ideas

Maieutic prompting

Method

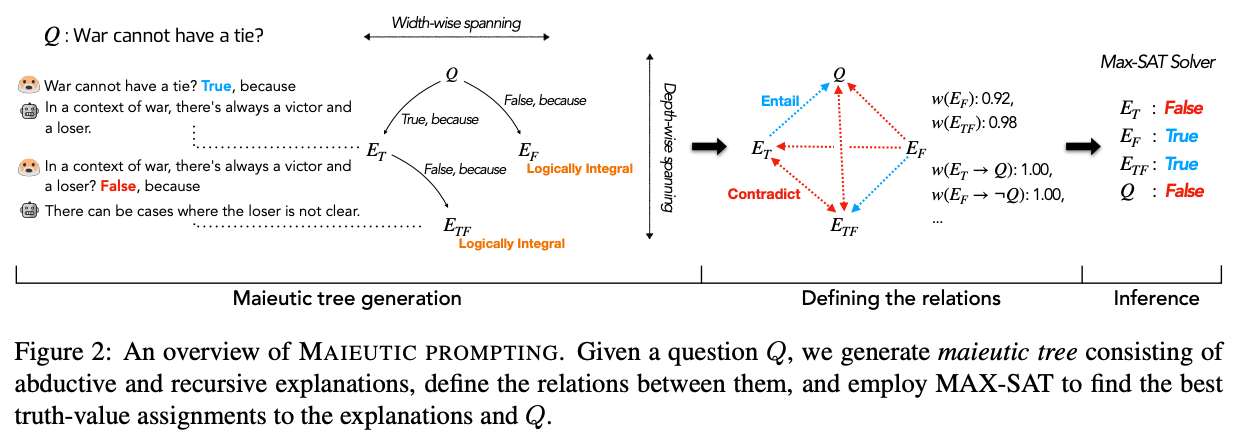

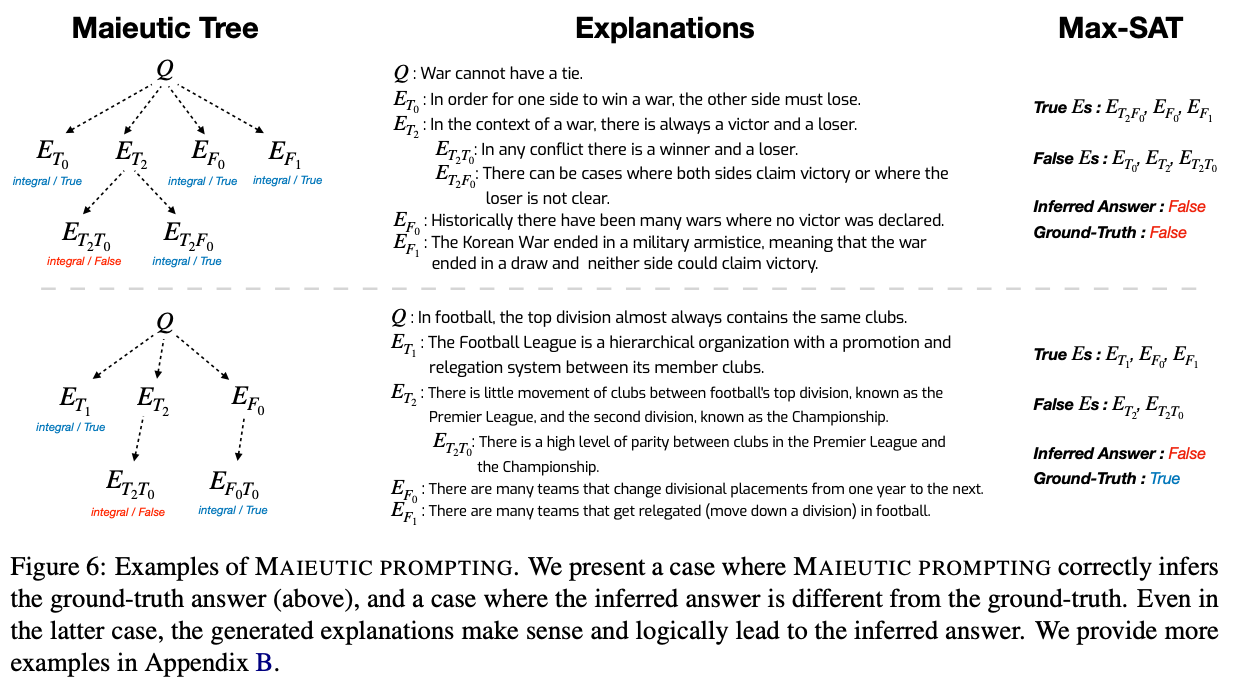

정답을 받을 확률을 최대화 하려는 이전의 테크닉들과는 달리 다른 접근법은 (정답이든 오답이든) 가능한 explanation들 의 tree를 발생시키도록 하기 위해 GPT-3를 사용합니다. 그리고 나서 어떤 세트가 correct한지 를 알아내기 위해 그들의 관계들을 분석합니다. 이 테크닉은 2022년 5월에 정재훈 등에 의해 만들어진 coined maieutic 프롬프팅입니다. (maieutic은 아이디어를 이끌어내기 위해 질문하는 소크라테스 식 방법과 관련 돼 있습니다.)

이 방법은 복잡합니다. 아래와 같이 작동합니다.

- First, build a maieutic tree, where each node is a statement that could be true or false:

- 첫째로 maieutic tree를 만듭니다. 각 노드는 참이나 거짓이 될 수 있는 하나의 statement 입니다.

- Start with a multiple-choice question or true/false statement (e.g. War cannot have a tie)

- 객관식 질문 또는 참/거짓을 답할 수 있는 질문으로 시작합니다. (예. 전쟁은 무승부일 수 없다)

- For each possible answer to the question, use the model to generate a corresponding explanation (with a prompt like War cannot have a tie? True, because)

- 질문에 대해 각각의 가능한 answer 들에 대해 각각 상응하는 explanation을 생성하도록 모델을 사용합니다. (전쟁은 무승부일 수 없다? 참, 왜냐하면... 같은 프롬프트가 될 것입니다.)

- Then, prompt the model with the question and the generated explanation, and ask it to produce the answer. If reversing the explanation (with a prefix like It is wrong to say that {explanation}) reverses the answer, then the explanation is considered 'logically integral.'

- 그런 다음 질문과 생성된 explanation으로 모델의 프롬프트를 만듭니다. 그리고 나서 답을 만들도록 요청합니다. 만약 설명을 뒤집으면 (예를 들어 {explanation} 이라고 얘기하면 틀립니다와 같은 prifix를 만드는 방법)답도 뒤집어 집니다. 그러면 explanation은 "logically integral" 로 간주되게 됩니다.

- If an explanation is not logically integral, then repeat the above process recursively, with each explanation turned into a True or False question, and generate more explanations for each new question.

- 만약 explanation이 logically integral 되지 않았다면 위의 과정을 재귀적으로 반복합니다. (이 때 각각의 explanation은 True 나 False question으로 바뀌게 되는 것이죠. 그리고 각각의 새로운 질문들에 대한 좀 더 많은 explanation들을 생성합니다.

- After all of the recursive explaining is done, you end up with a tree of explanations, where each leaf on the tree has the property that reversing the explanation reverses the model's answer.

- 이렇게 모든 재귀적인 explaining이 종류된 후에 explanation tree를 얻게 됩니다. 나무에 있는 각각의 leaf (잎)들은 explanation을 뒤집으면 모델의 답도 뒤집어지는 그런 프로퍼티를 갖게 됩니다.

- Second, convert the tree into a graph of relations:

- 두번째, 그 tree를 관계 그래프로 변환합니다.

- For each node in the tree, calculate the model's relative belief in each node (inferred from the probability of getting an answer of True to given an explanation)

- 그 나무의 각각의 노드들은 각 노드에 대한 모델의 상대적 신뢰도를 계산하게 됩니다. (주어진 explanation에 True라는 답을 얻기 위한 추정치로 부터 추론 합니다.)

- For each pair of nodes in the tree, use the model to identify whether they are entailed (implied) or contradicted

- 그 나무에 있는 노드들의 각 쌍들에 대해 그 쌍들이 그것들이 entailed (implied) 인지 contradicted (모순)인지의 여부를 모델을 사용하여 판정합니다.

- Third, find the most consistent set of beliefs and take those to be true:

- 세번째, 가장 일관성 있는 belief들을 찾아내서 그것들을 true라고 작업합니다.

- Specifically, using the strength of belief in each node and the logical relationships between them, formulate the problem as a weighted maximum satisfiability problem (MAX-SAT)

- 특히 각 노드의 신뢰도의 강도와 그들간의 논리적인 관계를 사용하여 weighted maximum satisfiability problem (MAX-SAT)로 그 문제를 공식화 합니다.

- Use a solver to the find the most self-consistent set of beliefs, and take those as true

- Solver를 사용하여 가장 self-consistent 한 belief들의 세트를 찾아 냅니다. 그리고 그것들을 true로 취합니다.

Maieutic Prompting: Logically Consistent Reasoning with Recursive Explanations

Despite their impressive capabilities, large pre-trained language models (LMs) struggle with consistent reasoning; recently, prompting LMs to generate explanations that self-guide the inference has emerged as a promising direction to amend this. However, t

arxiv.org

Results

Maieutic Prompting: Logically Consistent Reasoning with Recursive Explanations

Despite their impressive capabilities, large pre-trained language models (LMs) struggle with consistent reasoning; recently, prompting LMs to generate explanations that self-guide the inference has emerged as a promising direction to amend this. However, t

arxiv.org

Implications

복잡한 것 이외에도 이 방법은 한가지 한계가 있습니다. 그것은 객관식으로 제시할 수 있는 질문에만 적용되는 것으로 보인다는 겁니다.

To learn more, read the full paper.

Maieutic Prompting: Logically Consistent Reasoning with Recursive Explanations

Despite their impressive capabilities, large pre-trained language models (LMs) struggle with consistent reasoning; recently, prompting LMs to generate explanations that self-guide the inference has emerged as a promising direction to amend this. However, t

arxiv.org

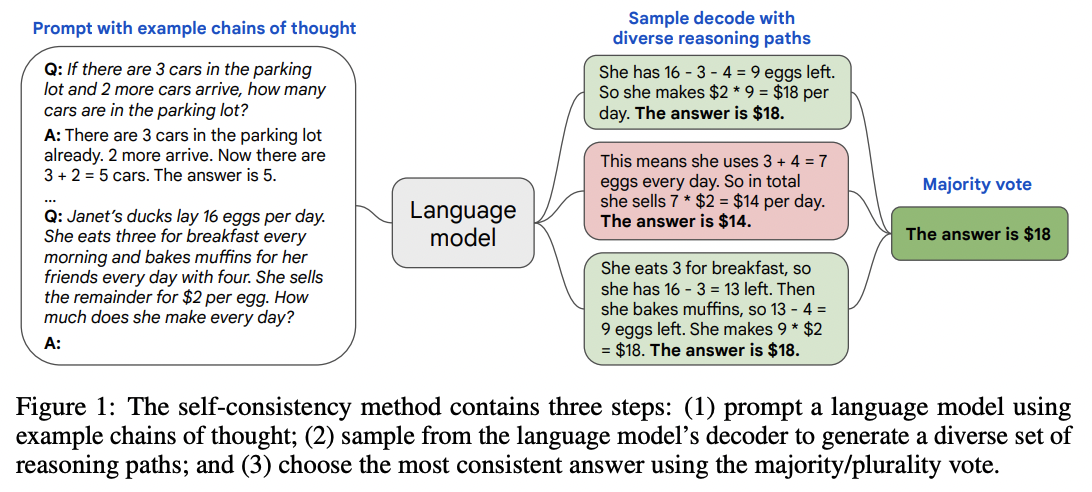

Extensions

Method

descrete set의 답변이 있는 task에 대해 신뢰도를 제고시킬 수 있는 간단한 방법 중 하나는 모델에서 여러 explanation 및 답변을 샘플링 한 다음에 (positive temperature를 사용) 가장 자주 등장하는 답변을 최종 답변으로 선택하는 겁니다.

Self-Consistency Improves Chain of Thought Reasoning in Language Models

Chain-of-thought prompting combined with pre-trained large language models has achieved encouraging results on complex reasoning tasks. In this paper, we propose a new decoding strategy, self-consistency, to replace the naive greedy decoding used in chain-

arxiv.org

Results

이 테크닉은 여러 수학과 reasoning benchmark들에서 정확도를 1~24 퍼센트 향상 시켰습니다. (아래 도표는 구글의 LamDa 모델의 결과 입니다. 구글의 larger PaLM 모델을 사용했습니다. 기준선은 높지만 그로부터 얻는 것은 약간 좀 더 작았습니다.)

Self-Consistency Improves Chain of Thought Reasoning in Language Models

Chain-of-thought prompting combined with pre-trained large language models has achieved encouraging results on complex reasoning tasks. In this paper, we propose a new decoding strategy, self-consistency, to replace the naive greedy decoding used in chain-

arxiv.org

Implications

이 테크닉은 구현이 간단하지만 비용이 많이 들 수 있습니다. 10개의 답변 세트를 생성하면 비용이 10배 증가합니다.

또한 많은 이러한 기술들과 마찬가지로 제한된 답변 세트가 있는 작업에만 적용할 수 있습니다. 각 답변이 유니크한 (시를 쓰는 것 처럼) 각각의 답변이 있는 open-ended 작업에 대해 가장 일반적인 답변을 하나 선택한다는 것은 과연 유의미한 건가에 대해서는 확언할 수는 없습니다.

마지막으로, 이 테크닉은 답을 얻기 위해 여러 경로나 여러 구문들이 있는 경우에 가장 유용합니다. 답변에 이르는 경로가 오직 하나 뿐이면 이 테크닉은 전혀 도움이 되지 않을 수 있습니다. 극단적인 예로 이 작업이 single token answer를 생성하는 것이라면 100개의 생성된 토큰 중 가장 일반적인 것을 가져오는 것은 가장 높은 logprobs(temperature=0 으로 생성된) 로 생성된 토큰을 가져오는 것과 다른 것이 없습니다.

Verifiers

작업 성능을 개선하기 위한 또 다른 주요한 테크닉은 main generative 모델의 output들을 평가하기 위한 verifier(검증자) 혹은 discriminator(판별자) 모델을 훈련 시키는 겁니다. 이 판별자가 output을 reject 한다면 acceptable output을 얻을 때까지 generative 모델을 resample 할 수 있습니다. 많은 경우 답을 만드는 것 보다 답을 판단하는 것이 더 쉽기 때문에 이 방법의 power를 설명하는데 도움이 됩니다.

Method

2021년에 OpenAI 연구자들은 이 테크닉을 아래와 같은 절차들을 사용해서 초등학교 수학 문제에 적용했습니다.

- First, they fine-tuned a model on questions and solutions

- 우선 질문과 솔루션에 대한 모델을 fine-tune 합니다.

- For each problem in the training set, they generated 100 solutions

- 훈련 세트에 있는 각 문제들에 대해 100개의 솔루션들을 생성합니다.

- Each of those 100 solutions was automatically labeled as either correct or incorrect, based on whether the final answer was correct

- 그 100개의 솔루션 각각은 정답인지 오답인지 자동적으로 label 됩니다. (정답/오답 근거는 최종 대답이 올바른지의 여부에 근거합니다.)

- Using those solutions, with some labeled correct and some labeled incorrect, they fine-tuned a verifier model to classify whether a question and candidate solution was correct or incorrect

- 이러한 솔루션을 사용하여 만든 어떤 레이블들은 옳고 또 어떤 레이블들은 그렇지 않았습니다. 그들은 문제와 후보 솔루션이 옳은지 옳지 않은지를 구별하는 verifier 모델을 fine-tune 했습니다.

- Finally, at test time, the generative model creates 100 solutions to each problem, and the one with the highest score according to the verifier model is picked as the final answer

- 마지막으로 테스트 할 때 generative 모델은 각 문제당 100개의 솔루션들을 만들었습니다. 그리고 그 verifier 모델에 의해 가장 높은 점수를 얻은 솔루션을 최종 답변으로 선택합니다.

Source: Training Verifiers to Solve Math Word Problems by Karl Cobbe et al. (2021)

Training Verifiers to Solve Math Word Problems

State-of-the-art language models can match human performance on many tasks, but they still struggle to robustly perform multi-step mathematical reasoning. To diagnose the failures of current models and support research, we introduce GSM8K, a dataset of 8.5

arxiv.org

Results

175B GPT-3 모델과 8천개의 training example들을 사용하여 이 테크닉은 초등학교 수학 문제에 대한 답변 정확도를 33%에서 55%로 높였습니다.

Source: Training Verifiers to Solve Math Word Problems by Karl Cobbe et al. (2021)

Training Verifiers to Solve Math Word Problems

State-of-the-art language models can match human performance on many tasks, but they still struggle to robustly perform multi-step mathematical reasoning. To diagnose the failures of current models and support research, we introduce GSM8K, a dataset of 8.5

arxiv.org

Implications

self-consistency 테크닉과 비슷하게 이 방법은 작업당 100개의 솔루션들을 생성하기 위해 100배의 비용이 더 들 수 있습니다.

Theories of reliability

위에서 다룬 테크닉들은 그 접근 방식들이 다르지만 목표는 모두 복잡한 작업에 대한 신뢰도(안정성)를 개선시키기 위한 것들입니다. 그 테크닉들은 대개 아래와 같은 방식으로 작업을 수행합니다.

- decomposing unreliable operations into smaller, more reliable operations (e.g., selection-inference prompting)

- 신뢰도가 적은 작업을 더 작고 신뢰도가 높은 작업으로 분할 합니다. (예. selection-inference 프롬프팅)

- using multiple steps or multiple relationships to make the system's reliability greater than any individual component (e.g., maieutic prompting)

- 개별적인 component보다 더 높은 시스템의 신뢰도를 만들기 위해 여러 단계 혹은 여러 관계들을 사용합니다. (예 maieutic 프롬프팅)

Probabilistic graphical models

덜 신뢰할 수 있는 component들로부터 신뢰할 수 있는 시스템을 만들기 위한 이 패러다임은 probabilistic (확률적) 프로그래밍을 연상시킵니다. 그리고 그 분야의 많은 분석 기술들 또한 여기에 적용될 수 있습니다.

David Dohan 등이 작성한 Language Model Cascades 라는 논문에서는 확률적 그래픽 모델의 패러다임으로 위의 기술들을 해석합니다.

Chain of thought prompting

Source: Language Model Cascades by David Dohan et al. (2022)

Language Model Cascades

Prompted models have demonstrated impressive few-shot learning abilities. Repeated interactions at test-time with a single model, or the composition of multiple models together, further expands capabilities. These compositions are probabilistic models, and

arxiv.org

Fine-tuned chain of thought prompting / Self-taught reasoner

Source: Language Model Cascades by David Dohan et al. (2022)

Language Model Cascades

Prompted models have demonstrated impressive few-shot learning abilities. Repeated interactions at test-time with a single model, or the composition of multiple models together, further expands capabilities. These compositions are probabilistic models, and

arxiv.org

Selection-inference prompting

Source: Language Model Cascades by David Dohan et al. (2022)

Language Model Cascades

Prompted models have demonstrated impressive few-shot learning abilities. Repeated interactions at test-time with a single model, or the composition of multiple models together, further expands capabilities. These compositions are probabilistic models, and

arxiv.org

Verifiers

Source: Language Model Cascades by David Dohan et al. (2022)

Language Model Cascades

Prompted models have demonstrated impressive few-shot learning abilities. Repeated interactions at test-time with a single model, or the composition of multiple models together, further expands capabilities. These compositions are probabilistic models, and

arxiv.org

Implications

이러한 테크닉들을 확률적 그래픽 모델로서 공식화 하는 것은 특정 문제를 해결하는데 곧바로 유용한 방법으로 사용할 수는 없을 수 있습니다. 하지만 이 프레임워크는 새로운 기술을 선택, 결합 그리고 발견하는데 도움이 될 수 있습니다.

Closing thoughts

Large language 모델을 연구하는 것은 매우 활발하고 빠르게 발전하고 있습니다. 연구자들은 계속해서 모델을 개선할 뿐만 아니라 모델을 가장 잘 활용하는 방법에 대한 이해도 지속적으로 향상 시키고 있습니다. 위에서 공유한 모든 논문은 지난 12개월 이내에 출판된 것이라는 것이 최근에 더욱 활발하고 빠르게 발전하고 있다는 것을 보여 줍니다. (이 글은 2022년 9월에 작성함)

앞으로 더 나은 모델과 더 나은 기술이 발표 될 것으로 기대합니다. 여기에서 다룬 특정 기술이 미래의 새로운 모범 사례에 의해 잊혀지더라도 그 모델들에서 제시한 일반 원칙은 다른 전문가들의 유용한 도구의 핵심 개념으로 남을 것입니다.

Bibliography

Lesson Paper Date

| Break complex tasks into simpler subtasks (and consider exposing the intermediate outputs to users) | AI Chains: Transparent and Controllable Human-AI Interaction by Chaining Large Language Model Prompts | 2021 Oct |

| You can improve output by generating many candidates, and then picking the one that looks best | Training Verifiers to Solve Math Word Problems | 2021 Oct |

| On reasoning tasks, models do better when they reason step-by-step before answering | Chain of Thought Prompting Elicits Reasoning in Large Language Models | 2022 Jan |

| You can improve step-by-step reasoning by generating many explanation-answer outputs, and picking the most popular answer | Self-Consistency Improves Chain of Thought Reasoning in Language Models | 2022 Mar |

| If you want to fine-tune a step-by-step reasoner, you can do it with multiple-choice question & answer data alone | STaR: Bootstrapping Reasoning With Reasoning | 2022 Mar |

| The step-by-step reasoning method works great even with zero examples | Large Language Models are Zero-Shot Reasoners | 2022 May |

| You can do better than step-by-step reasoning by alternating a ‘selection’ prompt and an ‘inference’ prompt | Selection-Inference: Exploiting Large Language Models for Interpretable Logical Reasoning | 2022 May |

| On long reasoning problems, you can improve step-by-step reasoning by splitting the problem into pieces to solve incrementally | Least-to-most Prompting Enables Complex Reasoning in Large Language Models | 2022 May |

| You can have the model analyze both good and bogus explanations to figure out which set of explanations are most consistent | Maieutic Prompting: Logically Consistent Reasoning with Recursive Explanations | 2022 May |

| You can think about these techniques in terms of probabilistic programming, where systems comprise unreliable components | Language Model Cascades | 2022 Jul |

| You can eliminate hallucination with sentence label manipulation, and you can reduce wrong answers with a 'halter' prompt | Faithful Reasoning Using Large Language Models | 2022 Aug |

'Open AI > CookBook' 카테고리의 다른 글

| Openai cookbook : GPT-3 , Code explanation examples (0) | 2023.03.04 |

|---|---|

| Openai cookbook : GPT-3 , Code writing examples (0) | 2023.03.04 |

| Openai cookbook : GPT-3 , Text editing examples (0) | 2023.03.04 |

| Openai cookbook : GPT-3 , Text explanation examples (0) | 2023.03.04 |

| Openai cookbook : GPT-3 , Text writing examples (0) | 2023.03.03 |

| Openai cookbook : GPT - 3 , Guide How to work with large language models (0) | 2023.03.01 |

| Openai cookbook - API usage - How to stream completions (0) | 2023.03.01 |

| Openai cookbook - API usage - How to count tokens with tiktoken (0) | 2023.03.01 |

| Openai cookbook - API usage - How to handle rate limits (0) | 2023.02.28 |

| Openai cookbook - Embeddings - Embedding long inputs (1) | 2023.02.26 |