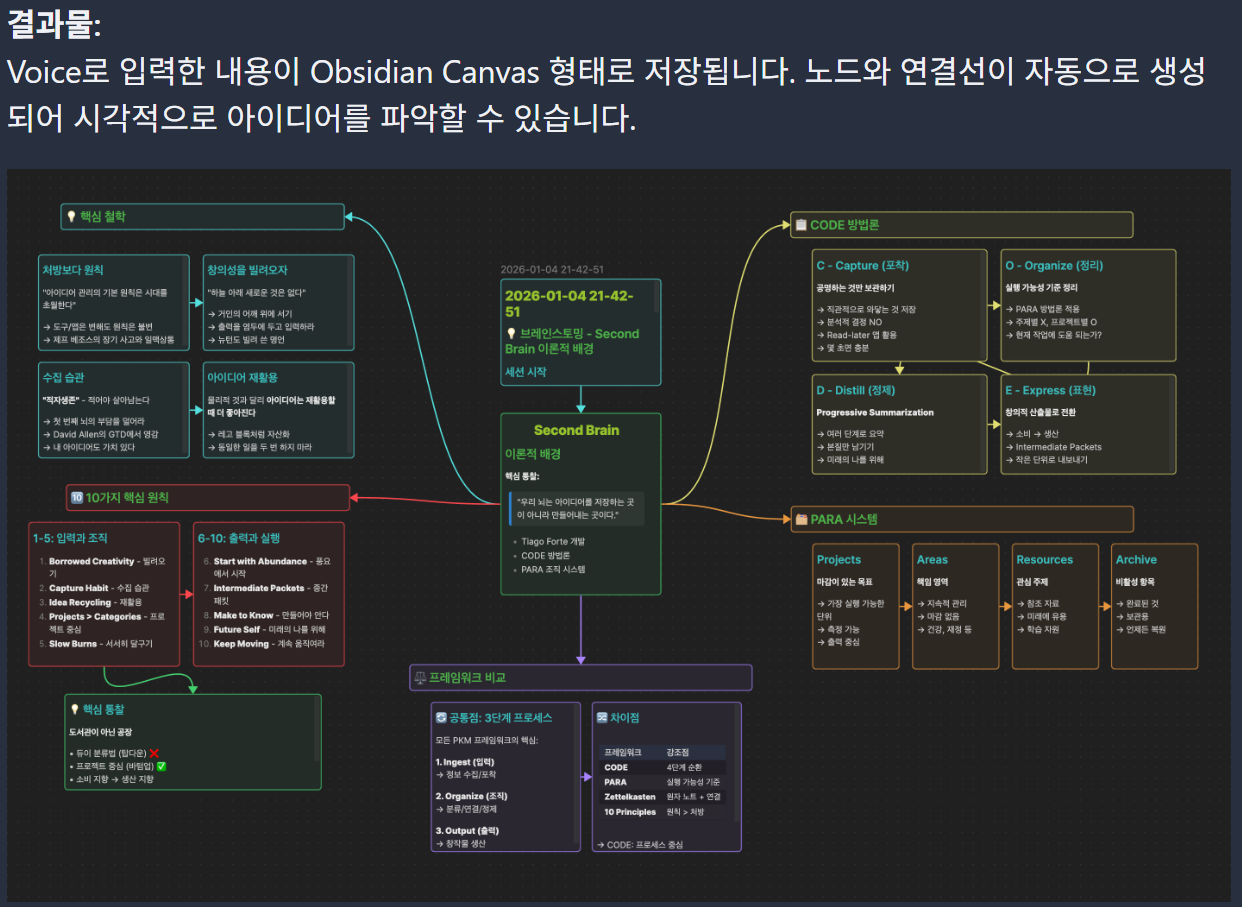

AI-powered PKM 실습 | 지식 정리부터 슬라이드·영상 제작까지 자동화, 외부 서비스가 아닌 내가 로컬에서 주도한다

2026. 1. 22. 02:43 |

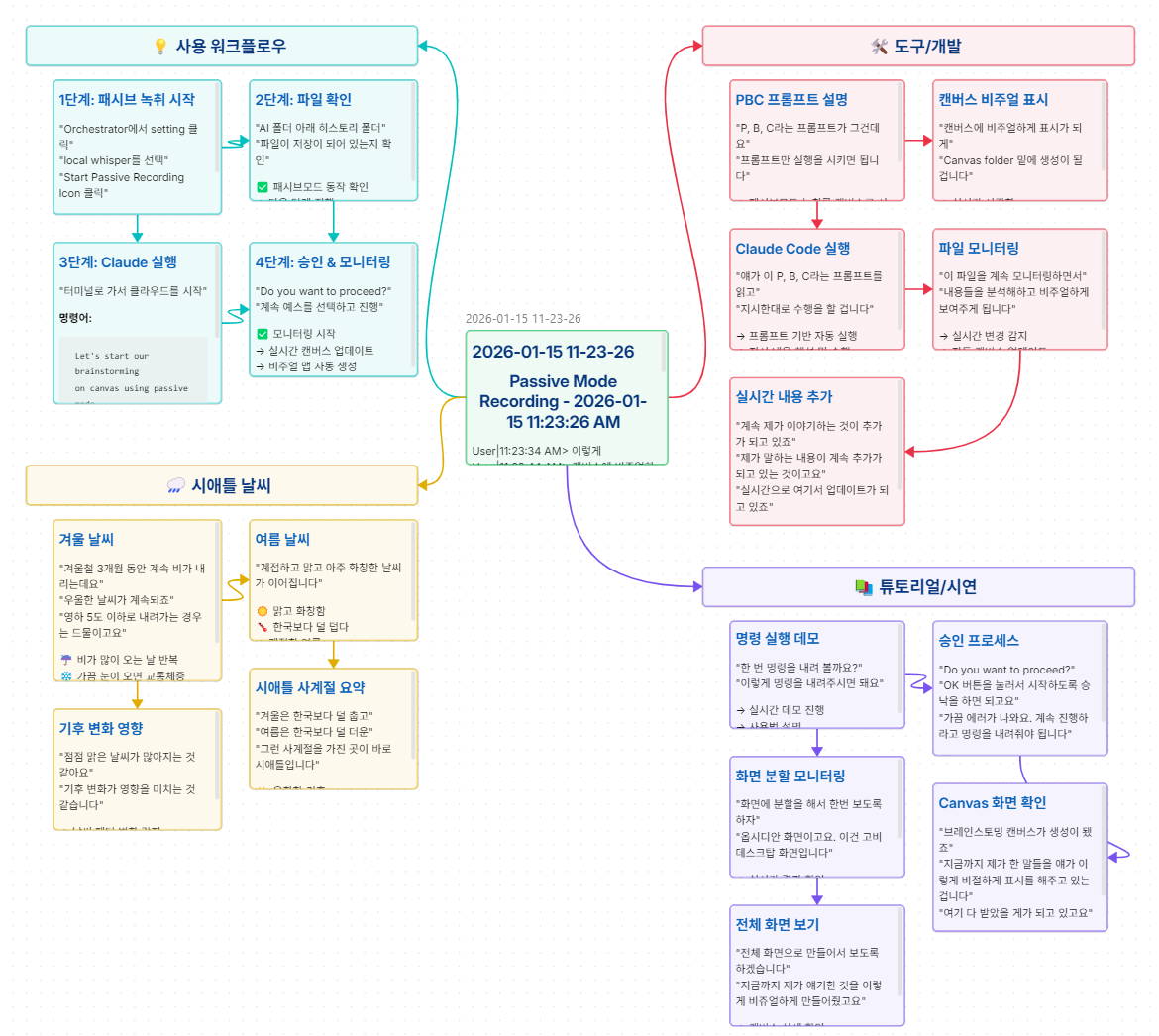

이번 영상에서는 AI4PKM 기반 실습을 통해

👉 지식 정리 → 슬라이드 제작 → 영상 생성까지

하나의 흐름으로 자동화하는 전체 과정을 직접 보여드립니다.

🎥 https://youtu.be/KoSIDAGEPAM?si=EC0n2neqHl8jAwlO

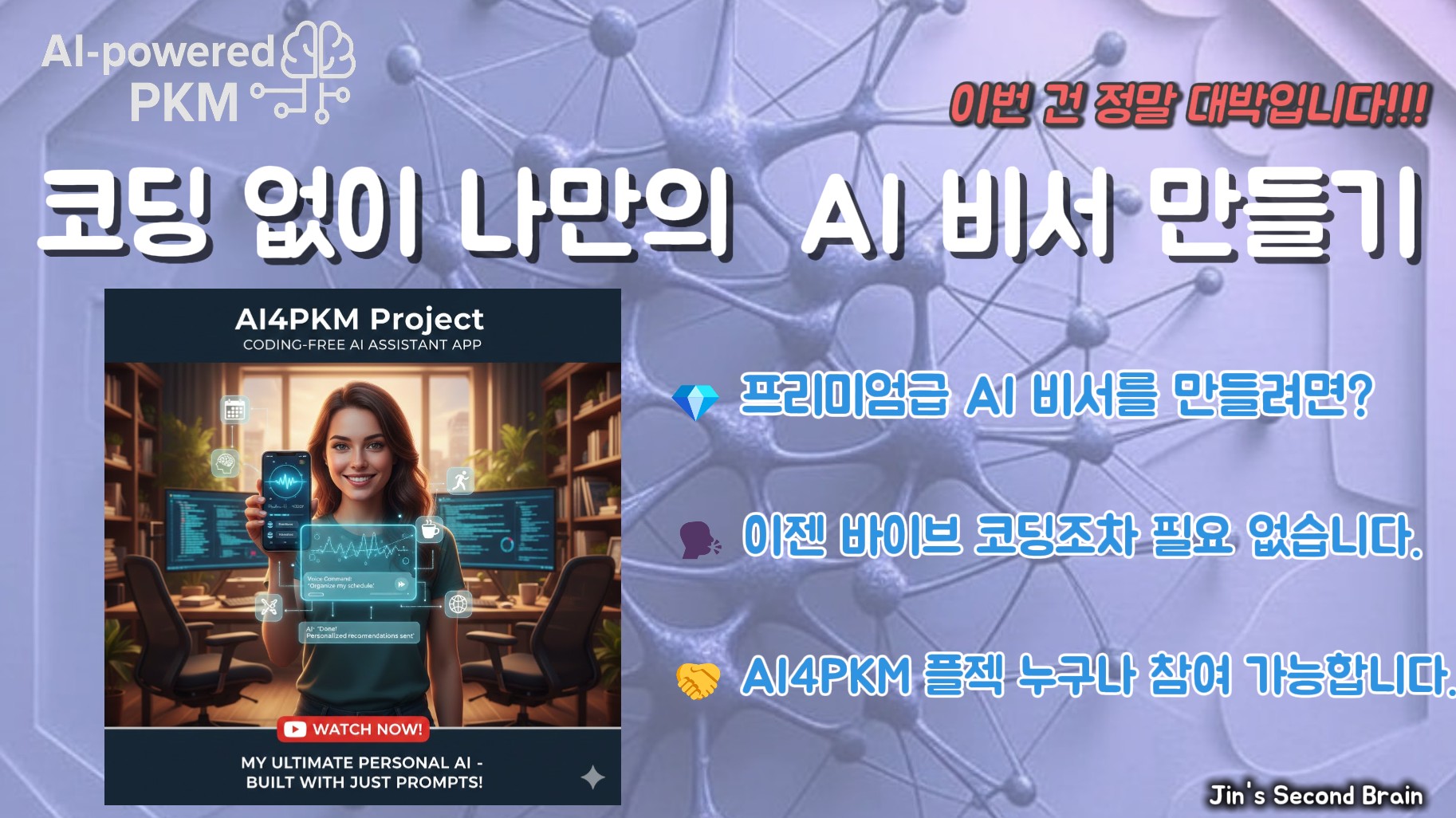

특히 이 영상의 핵심은

웹 서비스(NotebookLM, ChatGPT 등)를 수동적으로 사용하는 방식이 아니라,

내 로컬 환경에서 내가 주도적으로 AI를 활용하는 PKM 워크플로우를 실습한다는 점입니다.

🎯 이번 실습에서 다루는 핵심 기능

📅 Daily / Weekly 지식 자동 정리

- 하루·일주일 동안 쌓인 메모와 기록을 AI가 자동으로 정리

- 개인 지식 흐름을 지속적으로 축적하는 PKM 루틴

📝 마크다운 문서 기반 슬라이드 생성

- 정리된 지식 문서를 그대로 활용해 슬라이드(PPT) 제작

- 복사·붙여넣기 없는 문서 중심 워크플로우

🎬 로컬 환경에서 AI 영상 제작

- 외부 SaaS 없이 로컬에서 AI를 활용해 영상 생성

- 커뮤니티와 함께 만든 도구(GOBI Desktop 기반)로 실습

🧠 이 영상이 특별한 이유

❌ 외부 서비스 의존 없음

✅ 내 로컬 환경에서 직접 제어

✅ 지식 → 결과물(슬라이드·영상)까지 한 흐름

✅ AI를 “도구”가 아닌 작업 파트너로 활용

AI4PKM이 지향하는

**“로컬 주도 PKM(Local-first PKM)”**이 실제로 어떻게 구현되는지

이 영상 하나로 감을 잡으실 수 있습니다.

👀 이런 분들께 추천합니다

- AI로 지식 정리와 콘텐츠 제작을 함께 하고 싶은 분

- PKM을 단순 노트가 아닌 시스템으로 만들고 싶은 분

- 슬라이드·영상 제작을 자동화하고 싶은 분

- AI를 내 작업 환경에 깊이 통합하고 싶은 분

AI-powered PKM이 실제로 어디까지 가능한지,

함께 하나씩 확인해 보세요.

🔗 참고 링크 모음

📘 Cohort Onboarding Scenario Page

https://pub.aiforbetter.me/guide/onboarding-scenario-2026-01/

AI4PKM 온보딩 시나리오 (2026년 1월)

AI4PKM 온보딩 시나리오 이 문서는 2026년 1월 AI4BM Cohort 공유 예정인 내용입니다. 🔔 더 많은 소식을 받고 싶으시면 메일링 리스트에 가입해주세요! AI4PKM이란? AI4PKM은 개인 지식 관리를 AI의 도움을

pub.aiforbetter.me

✍ 2026 방향성 글 (Substack)

https://substack.com/home/post/p-183321475

2025년 PKM 교훈 & 2026년 방향성: 브레인 커뮤니티

2026년 1월 AI4PKM Cohort 모집중입니다!

substack.com

💬 AI4PKM Discord 참여하기

https://discord.gg/rSqWstpS

Discord - Group Chat That’s All Fun & Games

Discord is great for playing games and chilling with friends, or even building a worldwide community. Customize your own space to talk, play, and hang out.

discord.com

🎥 Obsidian & Web Clipper 설치 영상

https://youtu.be/Ku4_N4b78rc

🧠 AI4PKM 엔진 GitHub Repo

https://github.com/jykim/AI4PKM

GitHub - jykim/AI4PKM

Contribute to jykim/AI4PKM development by creating an account on GitHub.

github.com

📂 AI4PKM Vault Template GitHub Repo

https://github.com/jykim/ai4pkm-vault

GitHub - jykim/ai4pkm-vault

Contribute to jykim/ai4pkm-vault development by creating an account on GitHub.

github.com