https://python.langchain.com/docs/expression_language/cookbook/memory

Adding memory | 🦜️🔗 Langchain

This shows how to add memory to an arbitrary chain. Right now, you can use the memory classes but need to hook it up manually

python.langchain.com

This shows how to add memory to an arbitrary chain. Right now, you can use the memory classes but need to hook it up manually

임의의 체인에 메모리를 추가하는 방법을 보여줍니다. 지금은 메모리 클래스를 사용할 수 있지만 수동으로 연결해야 합니다.

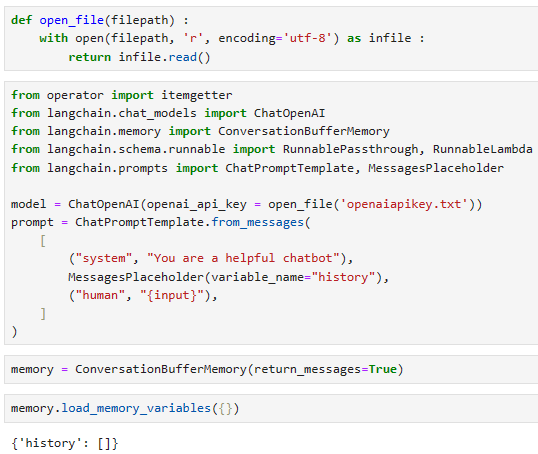

from operator import itemgetter

from langchain.chat_models import ChatOpenAI

from langchain.memory import ConversationBufferMemory

from langchain.schema.runnable import RunnablePassthrough, RunnableLambda

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder

model = ChatOpenAI()

prompt = ChatPromptTemplate.from_messages(

[

("system", "You are a helpful chatbot"),

MessagesPlaceholder(variable_name="history"),

("human", "{input}"),

]

)

memory = ConversationBufferMemory(return_messages=True)

memory.load_memory_variables({})

{'history': []}

이 코드는 LangChain에서 대화 기억 (memory)을 활용하는 방법을 설명합니다.

- ChatOpenAI 모델과 대화 기억 (memory) 객체 memory를 생성합니다. 이 모델과 대화 기억은 사용자와 상호 작용하고 대화 기록을 저장하고 검색하는 데 사용됩니다.

- ChatPromptTemplate을 사용하여 모델에 대한 프롬프트를 정의합니다. 여기에는 "system" 메시지와 사용자 입력을 나타내는 "human" 메시지가 포함됩니다. 중간에 MessagesPlaceholder가 있는데, 이것은 대화 기록 (history)를 삽입할 위치를 나타냅니다.

- 대화 기억 memory 객체를 초기화합니다. 이렇게 하면 대화 기록을 저장하고 검색할 수 있습니다.

대화 기억은 사용자와 모델 간의 상호 작용에서 발생하는 대화 기록을 저장하고 관리하는 데 사용됩니다. 이를 통해 모델은 이전 대화의 컨텍스트를 이해하고 이에 기반하여 응답을 생성할 수 있습니다.

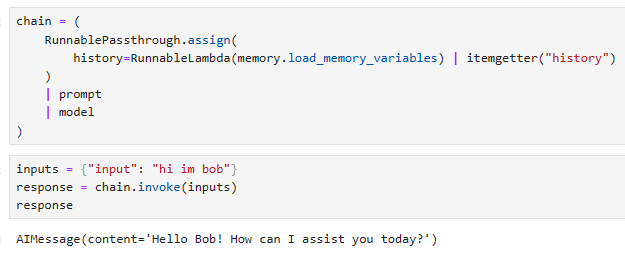

chain = (

RunnablePassthrough.assign(

history=RunnableLambda(memory.load_memory_variables) | itemgetter("history")

)

| prompt

| model

)

inputs = {"input": "hi im bob"}

response = chain.invoke(inputs)

response

AIMessage(content='Hello Bob! How can I assist you today?', additional_kwargs={}, example=False)

이 코드는 LangChain에서 대화 기억 (memory)을 활용하여 모델에 입력을 전달하고 응답을 얻는 과정을 설명합니다.

- RunnablePassthrough.assign 함수를 사용하여 history 변수를 설정합니다. 이 변수는 대화 기억에서 이전 대화 기록을 로드하고 저장합니다. RunnableLambda(memory.load_memory_variables)를 사용하여 대화 기억을 로드하고 itemgetter("history")로 해당 기억에서 "history"를 추출합니다.

- 대화 기록을 이전 대화와 함께 모델에 전달하는 chain을 설정합니다. prompt는 사용자 입력을 받아들이는 템플릿입니다. model은 모델로, 이전 단계에서 설정한 history와 사용자 입력을 모델에 전달하는 역할을 합니다.

- inputs 딕셔너리를 생성하고 사용자 입력으로 "hi im bob"을 설정합니다.

- chain.invoke(inputs)를 호출하여 모델에 입력을 전달하고 응답을 얻습니다.

이렇게하면 대화 기록과 사용자 입력이 모델에 전달되고, 모델은 이전 대화 내용을 고려하여 적절한 응답을 생성합니다. 결과인 response는 모델의 응답을 나타냅니다.

memory.save_context(inputs, {"output": response.content})

memory.load_memory_variables({})

{'history': [HumanMessage(content='hi im bob', additional_kwargs={}, example=False),

AIMessage(content='Hello Bob! How can I assist you today?', additional_kwargs={}, example=False)]}

이 코드는 LangChain에서 대화 기억 (memory)을 저장하고 다시 로드하는 과정을 설명합니다.

- memory.save_context(inputs, {"output": response.content}): 이 코드는 memory 객체를 사용하여 대화 기억에 입력과 응답을 저장합니다. inputs는 사용자 입력을 포함하는 딕셔너리이며, response.content는 모델의 응답 내용을 나타냅니다. 따라서 이전 대화 기록에 현재 대화 내용을 추가로 저장하는 것입니다.

- memory.load_memory_variables({}): 이 코드는 이전에 저장된 대화 기억을 로드합니다. 빈 딕셔너리 {}를 사용하여 현재 대화와 관련된 모든 이전 기억을 로드합니다.

이렇게하면 대화 기록이 지속적으로 누적되고 관리되며, 다음 대화에서 이전 대화 내용을 활용할 수 있습니다.

inputs = {"input": "whats my name"}

response = chain.invoke(inputs)

response

AIMessage(content='Your name is Bob.', additional_kwargs={}, example=False)

이 코드는 LangChain을 사용하여 모델에 질문을 제출하고 모델의 응답을 얻는 과정을 설명합니다.

- inputs 딕셔너리에 "input" 키를 사용하여 사용자의 입력을 정의합니다. 여기서 사용자는 "whats my name"이라는 질문을 입력했습니다.

- chain.invoke(inputs): chain은 ChatOpenAI 모델과 이전 대화 내용을 포함한 대화 prompt를 정의한 파트입니다. 이 코드는 inputs 딕셔너리를 사용하여 모델에 질문을 전달하고, 모델은 질문에 대한 응답을 생성합니다.

- response는 모델의 응답을 나타내는 객체입니다. 따라서 response 객체에는 모델의 응답 내용과 관련된 정보가 포함되어 있습니다.

이 코드를 실행하면 모델은 "whats my name"이라는 질문에 대한 응답을 생성하고, response 객체에 저장되어 반환됩니다. 이렇게 LangChain을 사용하여 모델에 대화를 제출하고 응답을 처리할 수 있습니다.

챗봇의 기능인 대화는 대화의 맥락이 유지 되어야 합니다. 즉 이전에 대화 했던 내용이 무엇인지 알아야 자연스럽게 대화기 이어 질 수 있습니다. 그러기 위해서는 이전의 질문과 대답을 ChatGPT가 알아야 합니다. ChatGPT가 기억하고 있지는 못합니다. API를 통해서 질문을 던질 때에는 현재의 질문에 이전에 했던 질문과 대답을 모두 같이 전달해 주어야 합니다.

LangChain의 Memory 기능은 이러한 작업을 간편하게 할 수 있도록 도와주는 것이네요.

'LangChain > LangChain Expression Language' 카테고리의 다른 글

| LC - Cookbook - Why use LCEL? (0) | 2023.11.07 |

|---|---|

| LC - Cookbook - Using tools (0) | 2023.11.07 |

| LC - Cookbook - Adding moderation (0) | 2023.11.07 |

| LC - Cookbook - Routing by semantic similarity (0) | 2023.11.07 |

| LC - Cookbook - Code Writing (1) | 2023.11.06 |

| LC - Cookbook - Agents (0) | 2023.11.06 |

| LC - Cookbook - Querying a SQL DB (0) | 2023.11.06 |

| LC - Cookbook - Multiple chains (0) | 2023.11.05 |

| LC - Cookbook - RAG (Retrieval-Augmented Generation) (0) | 2023.11.05 |

| LC - Cookbook - Prompt + LLM (1) | 2023.10.29 |