https://huggingface.co/learn/nlp-course/chapter1/6?fw=pt

Decoder models - Hugging Face NLP Course

2. Using 🤗 Transformers 3. Fine-tuning a pretrained model 4. Sharing models and tokenizers 5. The 🤗 Datasets library 6. The 🤗 Tokenizers library 9. Building and sharing demos new

huggingface.co

https://youtu.be/d_ixlCubqQw?si=K9zIkyOcYjir30si

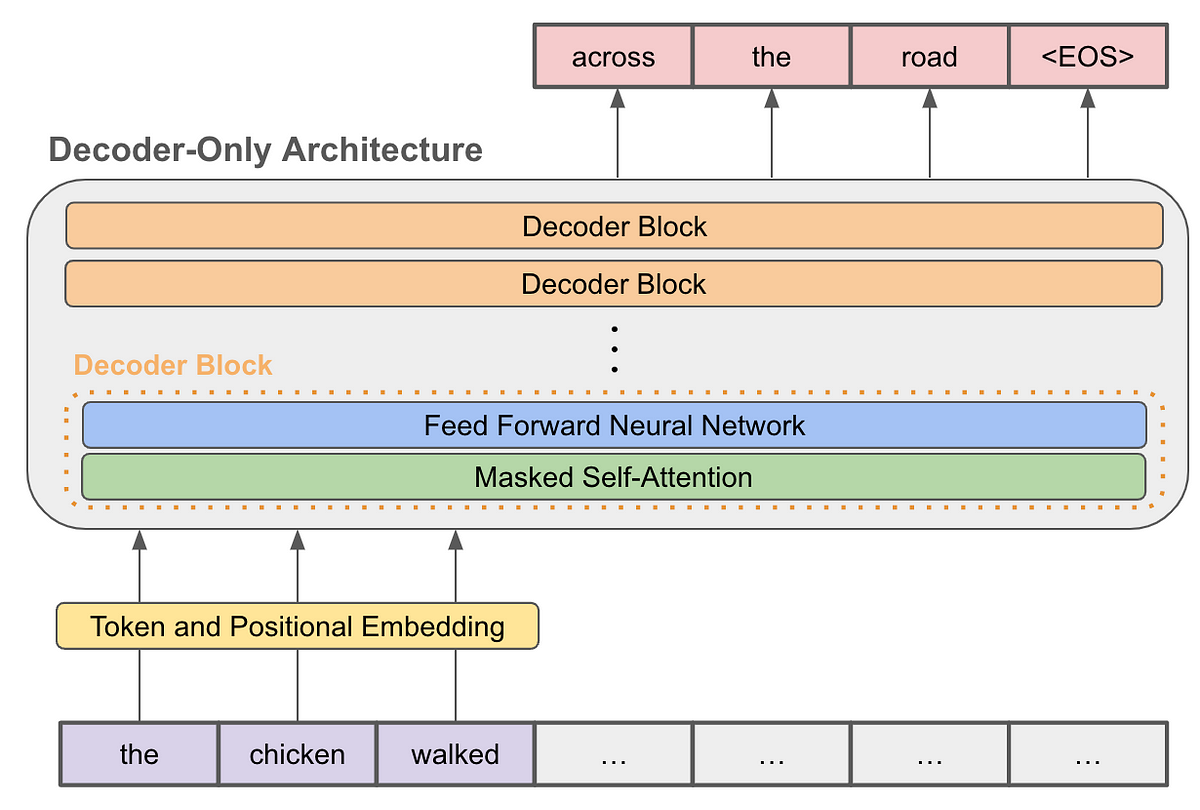

Decoder models use only the decoder of a Transformer model. At each stage, for a given word the attention layers can only access the words positioned before it in the sentence. These models are often called auto-regressive models.

디코더 모델은 Transformer 모델의 디코더만 사용합니다. 각 단계에서 주어진 단어에 대해 어텐션 레이어는 문장에서 그 단어 앞에 위치한 단어에만 접근할 수 있습니다. 이러한 모델을 종종 자동 회귀 모델이라고 합니다.

The pretraining of decoder models usually revolves around predicting the next word in the sentence.

디코더 모델의 사전 학습은 일반적으로 문장의 다음 단어를 예측하는 것입니다.

These models are best suited for tasks involving text generation.

이러한 모델은 텍스트 생성과 관련된 작업에 가장 적합합니다.

Representatives of this family of models include:

이 모델 제품군의 대표자는 다음과 같습니다.

'Hugging Face > NLP Course' 카테고리의 다른 글

| HF-NLP-USING 🤗 TRANSFORMERS : Introduction (0) | 2023.12.24 |

|---|---|

| HF-NLP-Transformer models : End-of-chapter quiz (1) | 2023.12.24 |

| HF-NLP-Transformer models : Summary (0) | 2023.12.24 |

| HF-NLP-Transformer models : Bias and limitations (1) | 2023.12.24 |

| HF-NLP-Transformer models : Sequence-to-sequence models[sequence-to-sequence-models] (1) | 2023.12.24 |

| HF-NLP-Transformer models : Encoder models (1) | 2023.12.24 |

| HF-NLP-Transformer models : How do Transformers work? (1) | 2023.12.24 |

| HF-NLP-Transformer models : Transformers, what can they do? (0) | 2023.12.23 |

| HF-NLP-Transformer models : Natural Language Processing (0) | 2023.12.19 |

| HF-NLP-Transformer models : Introduction (0) | 2023.12.19 |