https://huggingface.co/learn/nlp-course/chapter3/1?fw=pt

Introduction - Hugging Face NLP Course

2. Using 🤗 Transformers 3. Fine-tuning a pretrained model 4. Sharing models and tokenizers 5. The 🤗 Datasets library 6. The 🤗 Tokenizers library 9. Building and sharing demos new

huggingface.co

Introduction

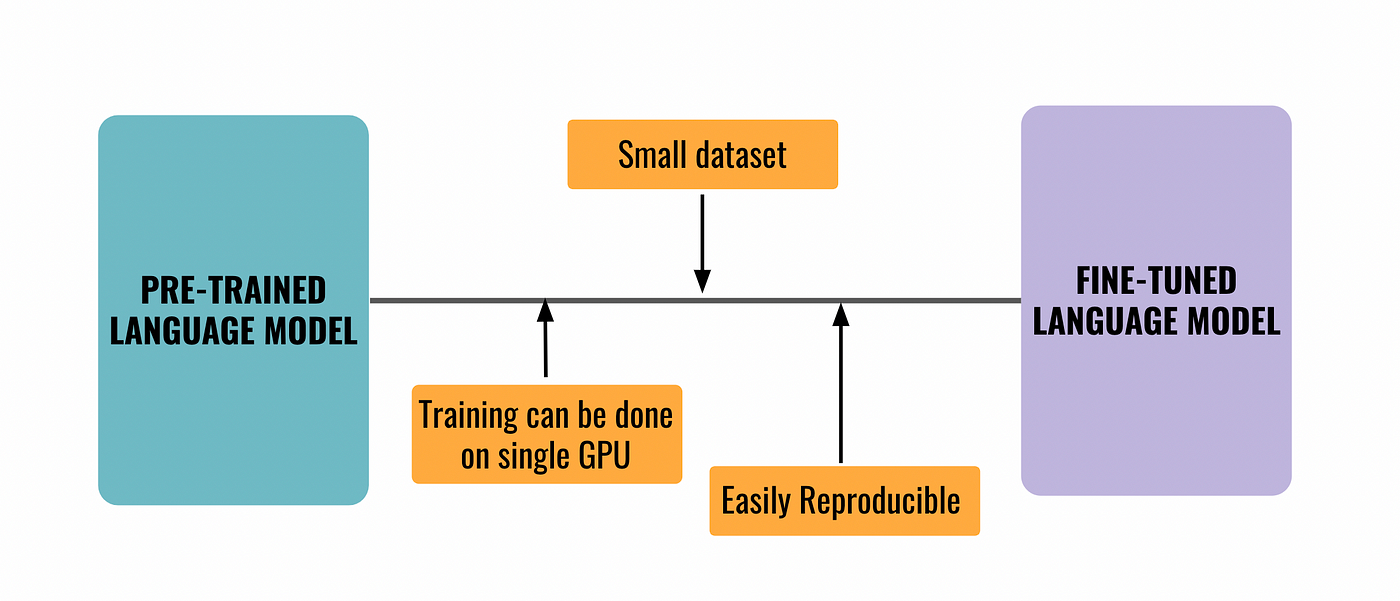

In Chapter 2 we explored how to use tokenizers and pretrained models to make predictions. But what if you want to fine-tune a pretrained model for your own dataset? That’s the topic of this chapter! You will learn:

2장에서는 토크나이저와 사전 훈련된 모델을 사용하여 예측을 수행하는 방법을 살펴보았습니다. 하지만 자신의 데이터 세트에 맞게 사전 훈련된 모델을 미세 조정하려면 어떻게 해야 할까요? 이것이 이번 장의 주제입니다! 당신은 배울 것이다:

- How to prepare a large dataset from the Hub

- 허브에서 대규모 데이터세트를 준비하는 방법

- How to use the high-level Trainer API to fine-tune a model

- 상위 수준 Trainer API를 사용하여 모델을 미세 조정하는 방법

- How to use a custom training loop

- 맞춤형 훈련 루프를 사용하는 방법

- How to leverage the 🤗 Accelerate library to easily run that custom training loop on any distributed setup

- 🤗 Accelerate 라이브러리를 활용하여 모든 분산 설정에서 사용자 정의 훈련 루프를 쉽게 실행하는 방법

In order to upload your trained checkpoints to the Hugging Face Hub, you will need a huggingface.co account: create an account

훈련된 체크포인트를 Hugging Face Hub에 업로드하려면 Huggingface.co 계정이 필요합니다. 계정을 만드세요.

'Hugging Face > NLP Course' 카테고리의 다른 글

| HF-NLP-SHARING MODELS AND TOKENIZERS-The Hugging Face Hub (0) | 2023.12.26 |

|---|---|

| HF-NLP-FINE-TUNING A PRETRAINED MODEL-Fine-tuning, Check! (1) | 2023.12.26 |

| HF-NLP-FINE-TUNING A PRETRAINED MODEL-A full training (1) | 2023.12.26 |

| HF-NLP-FINE-TUNING A PRETRAINED MODEL-Fine-tuning a model with the Trainer API (1) | 2023.12.26 |

| HF-NLP-FINE-TUNING A PRETRAINED MODEL-Processing the data (1) | 2023.12.26 |

| HF-NLP-USING 🤗 TRANSFORMERS : End-of-chapter quiz (0) | 2023.12.25 |

| HF-NLP-USING 🤗 TRANSFORMERS : Basic usage completed! (0) | 2023.12.25 |

| HF-NLP-USING 🤗 TRANSFORMERS : Putting it all together (0) | 2023.12.25 |

| HF-NLP-USING 🤗 TRANSFORMERS : Handling multiple sequences (0) | 2023.12.25 |

| HF-NLP-USING 🤗 TRANSFORMERS : Tokenizers (1) | 2023.12.25 |